Hello Hivers!

Today I wanted to share a practical guide to integrate DeepSeek-R1, a language model specialized in code and mathematical reasoning, into our local development environment using Ollama and Visual Studio Code. This allows us to leverage this AI without relying on the cloud and optimize our productivity.

What is DeepSeek-R1?

DeepSeek-R1 is an open-source language model trained for programming tasks, data analysis, and technical problem-solving. It excels at:

- Advanced code understanding (Python, JavaScript, Java, etc.).

- Mathematical and logical capabilities.

- Efficient and contextual responses.

- Flexibility to customize its behavior.

Why use it locally?

- Privacy: Your data and code never leave your machine.

- Speed & Availability: While dependent on your computer's resources, it remains always available with no remote server latency.

- Offline: Works without an internet connection.

- Customization: Tailor it to your specific needs.

Integrating it into VS Code enables:

- Smart autocompletion.

- Assisted debugging.

- Rapid code generation (boilerplate).

- Real-time technical explanations.

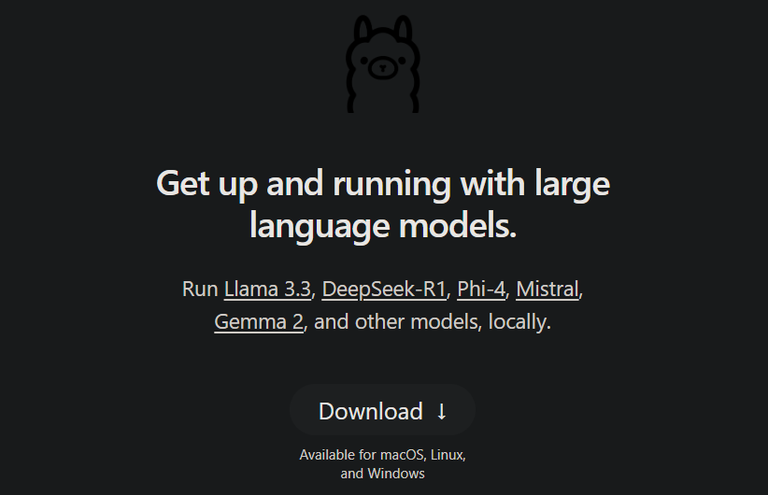

Step 1: Install Ollama

Ollama is an open-source platform designed to run and manage large language models (LLMs) locally on your machine. It acts as a model manager, simplifying the download, configuration, and use of LLMs (like DeepSeek-R1, Llama 3, Mistral, etc.).

Installation on Linux:

curl -fsSL https://ollama.com/install.sh | sh

Installation on Windows:

Download the installer from the Ollama website.

Run the .exe file and follow the prompts.

Step 2: Download DeepSeek-R1

Open your terminal and run:

ollama run deepseek-r1

Ollama will automatically download the model the first time. By default, it downloads the 7b version, trained with 7 billion parameters and requiring at least 8GB of RAM for optimal performance. To use a different version, specify it explicitly.

For example, if you have a low-resource PC, you could use the 1.5b version by running:

ollama run deepseek-r1:1.5b

Check the available distilled versions of DeepSeek-R1 here.

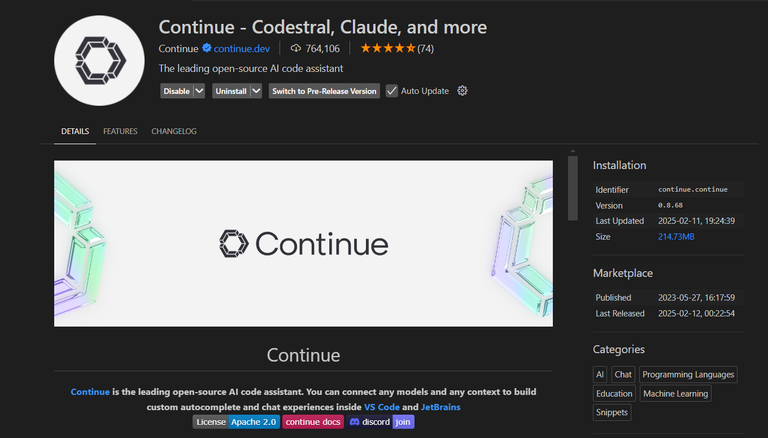

Step 3: Integrate with Visual Studio Code

Install the Continue extension in VS Code: Search for the extension in the VS Code Marketplace and click Install.

Configure the Ollama connection:

- Open the command palette in VS Code (Ctrl/Cmd + Shift + P).

- Type and select: Continue: Open Config JSON.

- Modify the config.json file to include DeepSeek-R1:

{ "models": [ { "title": "DeepSeek-R1 (Local)", "model": "deepseek-r1", "apiBase": "http://localhost:11434", "provider": "ollama", "temperature": 0.3 } ] }Parameter explanations:

- model: The downloaded distilled model.

- apiBase: Ollama's URL (default port 11434).

- temperature: Controls creativity (0 = precise, 1 = creative).

- provider: Use "ollama" for local connections.

"model": "deepseek-r1:8b",

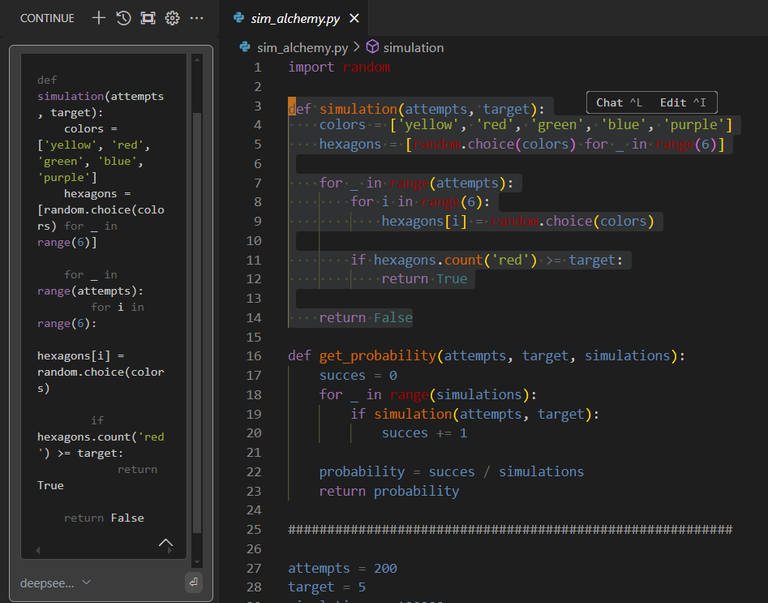

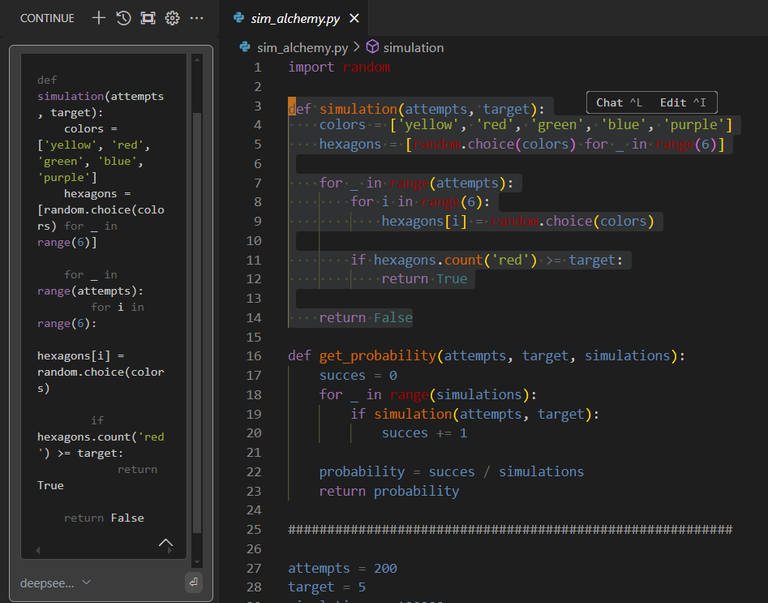

Use DeepSeek-R1 in Your Workflow

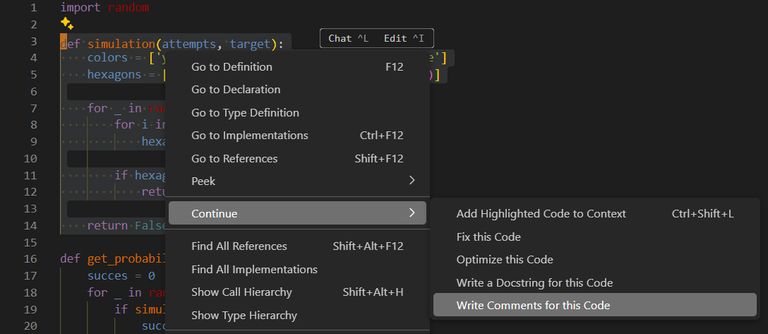

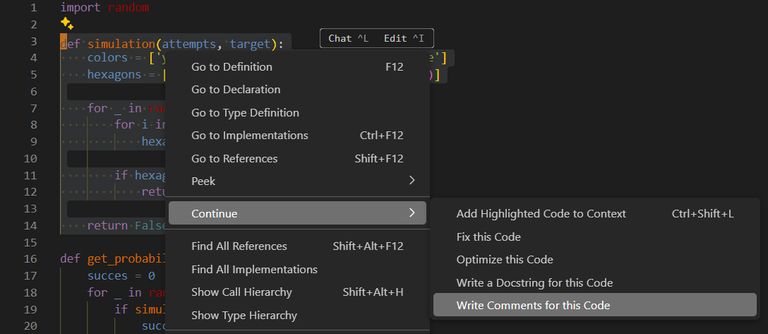

Quick shortcut: Select a code snippet and use Ctrl/Cmd + Shift + L to open Continue.

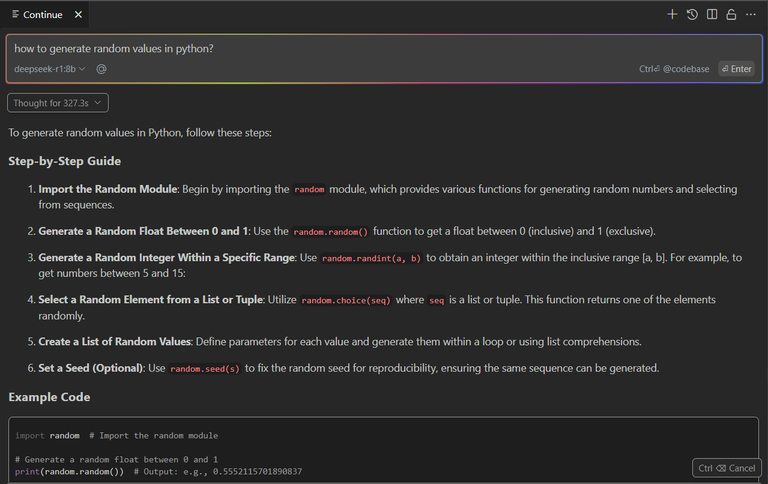

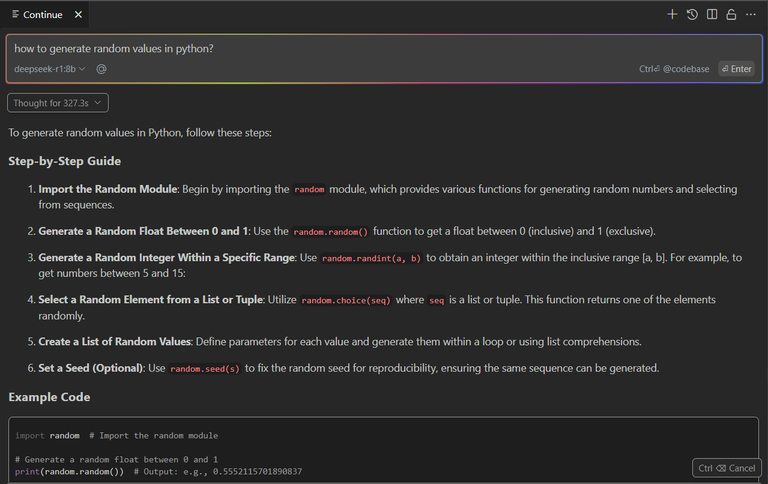

Interactive chat: Open the Continue sidebar tab (icon in the activity bar).

Ask questions or make queries:

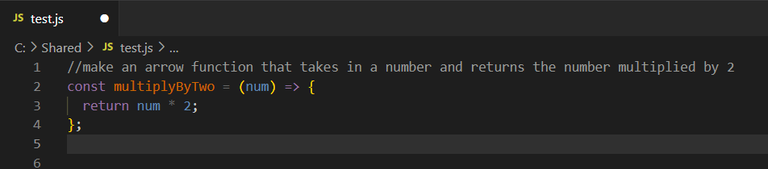

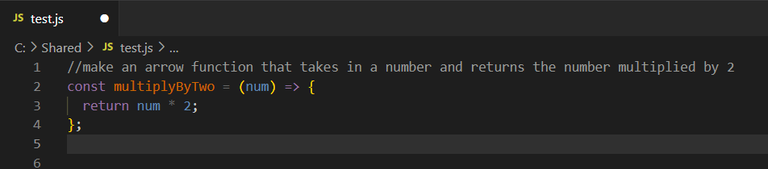

Generate code: Write a comment requesting a code snippet.

Docstrings & comments: Highlight a code block and use "Write a Docstring for this code" or "Write Comments for this code" to document it.

Using DeepSeek-R1 locally with Ollama gives you full control over the AI model, while integrating it into VS Code transforms your editor into a powerful productivity tool.

versión en español

Hola Hivers!

Hoy les quería compartir una guía práctica para integrar DeepSeek-R1, un modelo de lenguaje especializado en código y razonamiento matemático, en nuestro entorno de desarrollo local usando Ollama y Visual Studio Code. de manera que se pueda aprovechar esta IA sin depender de la nube y optimizar nuestra productividad.

¿Qué es DeepSeek-R1?

DeepSeek-R1 es un modelo de lenguaje de código abierto entrenado para tareas de programación, análisis de datos y resolución de problemas técnicos. Destaca por:

- Entendimiento avanzado de código (Python, JavaScript, Java, etc.).

- Capacidades matemáticas y lógicas.

- Respuestas eficientes y contextuales.

- Flexibilidad para personalizar su comportamiento.

¿Por qué usarlo en local?

- Privacidad: Tus datos y código nunca salen de tu máquina.

- Velocidad y disponibilidad: Aunque depende en gran medida de los recursos de nuestro ordenador, estará disponible siempre y sin latencia de servidores remotos.

- Offline: Funciona sin conexión a internet.

- Personalización: Lo ajustas a tus necesidades específicas.

- Autocompletado inteligente.

- Debugging asistido.

- Generación de código rápido (maquetado).

- Explicaciones técnicas en tiempo real.

Paso 1: Instalar Ollama

Ollama es una plataforma open source diseñada para ejecutar y gestionar modelos de lenguaje grandes (LLMs) de forma local en tu máquina. Funciona como un gestor de modelos que simplifica la descarga, configuración y uso de LLMs (como DeepSeek-R1, Llama 3, Mistral, etc.)

Instalacion en Linux:

curl -fsSL https://ollama.com/install.sh | sh

Instalacion en Windows:

Descargamos el instalador desde la pagina web de Ollama .

Ejecutamos el archivo .exe y seguimos los pasos.

Paso 2: Descargar DeepSeek-R1

Abre tu terminal y ejecuta:

ollama run deepseek-r1Ollama descargará automáticamente el modelo la primera vez. Por defecto estará descargando la versión 7b, entrenada con 7 billones de parámetros y que necesita al menos unos 8GB de RAM para un buen funcionamiento. Si queremos una versión distinta deberíamos especificarla.

Por ejemplo si tenemos una PC con recursos muy limitados, podríamos usar la version 1.5b. Para ello deberiamos ejecutar el comando:

ollama run deepseek-r1:1.5b

Aqui puedes ver las distintas versiones destiladas de DeepSeek-r1 que se pueden usar.

Paso 3: Integrar con Visual Studio Code

Instalar la extensión Continue en VS Code:

Busca la extensión en el marketplace de VS Code y haz clic en Install.

Configurar la conexión a Ollama:

- Abre la paleta de comandos en VS Code (Ctrl/Cmd + Shift + P).

- Escribe y selecciona: Continue: Open Config JSON.

- Modifica el archivo config.json para incluir DeepSeek-R1:

{ "models": [ { "title": "DeepSeek-R1 (Local)", "model": "deepseek-r1", "apiBase": "http://localhost:11434", "provider": "ollama", "temperature": 0.3 } ] }Explicación de parámetros:

- model: El modelo destilado que hemos descargado.

- apiBase: URL de Ollama (puerto 11434 por defecto).

- temperature: Controla la creatividad (0 = preciso, 1 = creativo).

- provider: El proveedor "ollama" para conexiones locales.

Nota: si anteriormente instalamos otra version de DeepSeek debemos especificar el modelo, por ejemplo:

"model": "deepseek-r1:8b",

Usar DeepSeek-R1 en tu flujo de trabajo

Atajo clave: Selecciona una porción de código y usa Ctrl/Cmd + Shift + L para abrir Continue.

Chat interactivo: Abre la pestaña lateral de Continue (icono en la barra de actividades).

Escribe alguna pregunta o realiza una consulta:

Generar código: Escribe un comentario para pedir un fragmento de codigo.

Docstrings y comentarios: Resalta un bloque y usa "Write a Docstring for this code" o "Write Comments for this code" para documentar el código.

Usar DeepSeek-R1 en local con Ollama te da control total sobre el modelo de IA, mientras que integrarlo en VS Code transforma tu editor en una potente herramienta de trabajo.

That's interesting. Is it resource-intensive?

Hello, it depends on the model you are going to use, there are light models like the 1.5b that does not consume much and would work without problems in an average PC. There are also large models up to 671b that is impossible to run on a single PC, for that you need clusters of several powerful computers.

If your pc has less than 8GB of RAM I recommend the 1.5b and if you have more than that you can try 7b or 8b.