If you prefer the English version, please click 👉 HERE

ᑕOᗰO SIᕮᗰᑭᖇᕮ, ᑕᕼIᑎᗩ ᑕOᑭIᗩ, ᑭᕮᖇO ᗩᕼOᖇᗩ ᗰᕮᒍOᖇᗩ

𝔻𝕖𝕖𝕡𝕊𝕖𝕖𝕜 ℝ𝟙 𝕣𝕖𝕡𝕣𝕖𝕤𝕖𝕟𝕥𝕒 𝕦𝕟 𝕒𝕧𝕒𝕟𝕔𝕖 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒𝕥𝕚𝕧𝕠 𝕖𝕟 𝕀𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝔸𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝, 𝕠𝕗𝕣𝕖𝕔𝕚𝕖𝕟𝕕𝕠 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕒𝕔𝕔𝕖𝕤𝕚𝕓𝕝𝕖𝕤 𝕡𝕒𝕣𝕒 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤. 𝔸 𝕕𝕚𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕀, ℝ𝟙 𝕦𝕥𝕚𝕝𝕚𝕫𝕒 𝕥𝕖́𝕔𝕟𝕚𝕔𝕒𝕤 𝕚𝕟𝕟𝕠𝕧𝕒𝕕𝕠𝕣𝕒𝕤 𝕢𝕦𝕖 𝕡𝕖𝕣𝕞𝕚𝕥𝕖𝕟 𝕦𝕟 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕞𝕒́𝕤 𝕓𝕒𝕣𝕒𝕥𝕠 𝕪 𝕖𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖. 𝔼𝕤𝕥𝕠 𝕕𝕖𝕞𝕠𝕔𝕣𝕒𝕥𝕚𝕫𝕒 𝕖𝕝 𝕒𝕔𝕔𝕖𝕤𝕠 𝕒 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕒𝕤, 𝕡𝕖𝕣𝕞𝕚𝕥𝕚𝕖𝕟𝕕𝕠 𝕒 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕞𝕒́𝕤 𝕡𝕖𝕢𝕦𝕖𝕟̃𝕒𝕤 𝕔𝕠𝕞𝕡𝕖𝕥𝕚𝕣 𝕖𝕟 𝕖𝕝 𝕞𝕖𝕣𝕔𝕒𝕕𝕠 𝕕𝕖 𝕝𝕒 𝕀𝔸.

𝕃𝕒 𝕔𝕣𝕖𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕔𝕠𝕞𝕠 𝔾ℙ𝕋 𝕪 ℝ𝟙 𝕣𝕖𝕡𝕣𝕖𝕤𝕖𝕟𝕥𝕒 𝕦𝕟 𝕔𝕒𝕞𝕓𝕚𝕠 𝕣𝕖𝕝𝕖𝕧𝕒𝕟𝕥𝕖 𝕖𝕟 𝕝𝕒 𝕗𝕠𝕣𝕞𝕒 𝕖𝕟 𝕢𝕦𝕖 𝕚𝕟𝕥𝕖𝕣𝕒𝕔𝕥𝕦𝕒𝕞𝕠𝕤 𝕔𝕠𝕟 𝕝𝕒 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒. 𝔼𝕤𝕥𝕠𝕤 𝕒𝕧𝕒𝕟𝕔𝕖𝕤 𝕖𝕤𝕥𝕒́𝕟 𝕣𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕒𝕟𝕕𝕠 𝕖𝕝 𝕒𝕔𝕔𝕖𝕤𝕠 𝕒 𝕝𝕒 𝕚𝕟𝕗𝕠𝕣𝕞𝕒𝕔𝕚𝕠́𝕟 𝕪 𝕝𝕒 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕔𝕚𝕠́𝕟. 𝕃𝕒 𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝔾ℙ𝕋 𝕞𝕦𝕖𝕤𝕥𝕣𝕒 𝕔𝕠́𝕞𝕠 𝕆𝕡𝕖𝕟𝔸𝕀 𝕙𝕒 𝕤𝕚𝕕𝕠 𝕡𝕚𝕠𝕟𝕖𝕣𝕠 𝕖𝕟 𝕖𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝. 𝔻𝕖𝕤𝕕𝕖 𝔾ℙ𝕋-𝟚 𝕙𝕒𝕤𝕥𝕒 𝔾ℙ𝕋-𝟛, 𝕔𝕒𝕕𝕒 𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕙𝕒 𝕞𝕖𝕛𝕠𝕣𝕒𝕕𝕠 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒𝕥𝕚𝕧𝕒𝕞𝕖𝕟𝕥𝕖. 𝕄𝕖𝕥𝕒 𝕪 𝕠𝕥𝕣𝕒𝕤 𝕘𝕣𝕒𝕟𝕕𝕖𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕖𝕤𝕥𝕒́𝕟 𝕥𝕣𝕒𝕥𝕒𝕟𝕕𝕠 𝕕𝕖 𝕞𝕒𝕟𝕥𝕖𝕟𝕖𝕣𝕤𝕖 𝕣𝕖𝕝𝕖𝕧𝕒𝕟𝕥𝕖𝕤 𝕖𝕟 𝕖𝕝 𝕒́𝕞𝕓𝕚𝕥𝕠 𝕕𝕖 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝. 𝕃𝕒 𝕔𝕣𝕖𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕔𝕠𝕞𝕠 𝕃𝕒𝕞𝕒 𝕖𝕤 𝕦𝕟 𝕚𝕟𝕥𝕖𝕟𝕥𝕠 𝕕𝕖 𝕔𝕠𝕞𝕡𝕖𝕥𝕚𝕣 𝕔𝕠𝕟 𝕘𝕚𝕘𝕒𝕟𝕥𝕖𝕤 𝕔𝕠𝕞𝕠 𝕆𝕡𝕖𝕟𝔸𝕀. 𝔼𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝔻𝕖𝕖𝕡𝕤 ℝ𝟙 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕢𝕦𝕖 𝕡𝕖𝕢𝕦𝕖𝕟̃𝕒𝕤 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤 𝕒𝕔𝕔𝕖𝕕𝕒𝕟 𝕒 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕒. 𝕊𝕦 𝕔𝕒𝕡𝕒𝕔𝕚𝕕𝕒𝕕 𝕡𝕒𝕣𝕒 𝕕𝕖𝕤𝕥𝕚𝕝𝕒𝕣 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕞𝕒́𝕤 𝕡𝕖𝕢𝕦𝕖𝕟̃𝕠𝕤 𝕪 𝕣𝕒́𝕡𝕚𝕕𝕠𝕤 𝕖𝕤 𝕔𝕣𝕦𝕔𝕚𝕒𝕝 𝕡𝕒𝕣𝕒 𝕝𝕒 𝕚𝕟𝕟𝕠𝕧𝕒𝕔𝕚𝕠́𝕟 𝕖𝕟 𝕖𝕝 𝕤𝕖𝕔𝕥𝕠𝕣.

𝔼𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 ℝ𝟙 𝕙𝕒 𝕔𝕒𝕞𝕓𝕚𝕒𝕕𝕠 𝕝𝕒 𝕗𝕠𝕣𝕞𝕒 𝕖𝕟 𝕢𝕦𝕖 𝕤𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕒𝕝 𝕤𝕖𝕣 𝕞𝕒́𝕤 𝕖𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖 𝕪 𝕒𝕔𝕔𝕖𝕤𝕚𝕓𝕝𝕖 𝕖𝕔𝕠𝕟𝕠́𝕞𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖. 𝔼𝕤𝕥𝕠 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕒 𝕝𝕒𝕤 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤 𝕒𝕔𝕔𝕖𝕕𝕖𝕣 𝕒 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕒𝕤 𝕤𝕚𝕟 𝕘𝕣𝕒𝕟𝕕𝕖𝕤 𝕚𝕟𝕧𝕖𝕣𝕤𝕚𝕠𝕟𝕖𝕤. 𝔼𝕝 𝕖𝕢𝕦𝕚𝕡𝕠 𝕕𝕖 ℍ𝕦𝕘𝕘𝕚𝕟𝕘 𝔽𝕒𝕔𝕖 𝕖𝕤𝕥𝕒́ 𝕥𝕣𝕒𝕓𝕒𝕛𝕒𝕟𝕕𝕠 𝕖𝕟 𝕣𝕖𝕡𝕝𝕚𝕔𝕒𝕣 𝕖𝕝 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 ℝ𝟙, 𝕝𝕠 𝕢𝕦𝕖 𝕡𝕠𝕕𝕣𝕚́𝕒 𝕧𝕒𝕝𝕚𝕕𝕒𝕣 𝕤𝕦 𝕖𝕗𝕖𝕔𝕥𝕚𝕧𝕚𝕕𝕒𝕕 𝕪 𝕒𝕔𝕔𝕖𝕤𝕚𝕓𝕚𝕝𝕚𝕕𝕒𝕕. 𝔼𝕤𝕥𝕠 𝕖𝕤 𝕦𝕟 𝕡𝕒𝕤𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒𝕟𝕥𝕖 𝕡𝕒𝕣𝕒 𝕝𝕒 𝕔𝕠𝕞𝕦𝕟𝕚𝕕𝕒𝕕 𝕕𝕖 𝕀𝔸. ℝ𝟙 𝕦𝕥𝕚𝕝𝕚𝕫𝕒 𝕥𝕖́𝕔𝕟𝕚𝕔𝕒𝕤 𝕚𝕟𝕟𝕠𝕧𝕒𝕕𝕠𝕣𝕒𝕤 𝕔𝕠𝕞𝕠 𝕖𝕝 𝕔𝕠𝕣𝕣𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕓𝕚𝕥𝕤 𝕡𝕒𝕣𝕒 𝕠𝕡𝕥𝕚𝕞𝕚𝕫𝕒𝕣 𝕖𝕝 𝕦𝕤𝕠 𝕕𝕖 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕪 𝕔𝕒𝕡𝕒𝕔𝕚𝕕𝕒𝕕 𝕕𝕖 𝕡𝕣𝕠𝕔𝕖𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠. 𝔼𝕤𝕥𝕠 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕦𝕟 𝕣𝕖𝕟𝕕𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕞𝕒́𝕤 𝕣𝕒́𝕡𝕚𝕕𝕠 𝕪 𝕖𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖.

𝕃𝕒 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕦𝕟𝕒 𝕗𝕦𝕟𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕣𝕖𝕔𝕠𝕞𝕡𝕖𝕟𝕤𝕒 𝕖𝕟 𝕖𝕝 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕞𝕖𝕛𝕠𝕣𝕒 𝕝𝕒 𝕔𝕒𝕝𝕚𝕕𝕒𝕕 𝕕𝕖 𝕝𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕘𝕖𝕟𝕖𝕣𝕒𝕕𝕒𝕤. 𝔼𝕤𝕥𝕠 𝕖𝕤 𝕔𝕝𝕒𝕧𝕖 𝕡𝕒𝕣𝕒 𝕙𝕒𝕔𝕖𝕣 𝕢𝕦𝕖 𝕝𝕒 𝕚𝕟𝕥𝕖𝕣𝕒𝕔𝕔𝕚𝕠́𝕟 𝕔𝕠𝕟 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕤𝕖𝕒 𝕞𝕒́𝕤 𝕟𝕒𝕥𝕦𝕣𝕒𝕝 𝕡𝕒𝕣𝕒 𝕝𝕠𝕤 𝕙𝕦𝕞𝕒𝕟𝕠𝕤. 𝔼𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕙𝕒 𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕒𝕕𝕠 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒𝕥𝕚𝕧𝕒𝕞𝕖𝕟𝕥𝕖, 𝕦𝕥𝕚𝕝𝕚𝕫𝕒𝕟𝕕𝕠 𝕒𝕡𝕣𝕖𝕟𝕕𝕚𝕫𝕒𝕛𝕖 𝕕𝕖 𝕣𝕖𝕗𝕦𝕖𝕣𝕫𝕠 𝕤𝕚𝕟 𝕟𝕖𝕔𝕖𝕤𝕚𝕕𝕒𝕕 𝕕𝕖 𝕚𝕟𝕥𝕖𝕣𝕧𝕖𝕟𝕔𝕚𝕠́𝕟 𝕙𝕦𝕞𝕒𝕟𝕒. 𝔼𝕤𝕥𝕠 𝕙𝕒 𝕡𝕖𝕣𝕞𝕚𝕥𝕚𝕕𝕠 𝕝𝕒 𝕔𝕣𝕖𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕞𝕒́𝕤 𝕖𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖𝕤 𝕪 𝕡𝕣𝕖𝕔𝕚𝕤𝕠𝕤.

𝔼𝕝 𝕒𝕛𝕦𝕤𝕥𝕖 𝕕𝕖 𝕡𝕣𝕖𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒, 𝕠 𝕡𝕣𝕖𝕗𝕖𝕣𝕖𝕟𝕔𝕖 𝕥𝕦𝕟𝕚𝕟𝕘, 𝕖𝕤 𝕔𝕣𝕦𝕔𝕚𝕒𝕝 𝕡𝕒𝕣𝕒 𝕢𝕦𝕖 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕤𝕚𝕘𝕒𝕟 𝕕𝕚𝕣𝕖𝕔𝕥𝕣𝕚𝕔𝕖𝕤 𝕒𝕝𝕚𝕟𝕖𝕒𝕕𝕒𝕤 𝕔𝕠𝕟 𝕝𝕒𝕤 𝕖𝕩𝕡𝕖𝕔𝕥𝕒𝕥𝕚𝕧𝕒𝕤 𝕙𝕦𝕞𝕒𝕟𝕒𝕤. 𝔼𝕤𝕥𝕠 𝕘𝕒𝕣𝕒𝕟𝕥𝕚𝕫𝕒 𝕢𝕦𝕖 𝕝𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕤𝕖𝕒𝕟 𝕒𝕕𝕖𝕔𝕦𝕒𝕕𝕒𝕤 𝕪 𝕤𝕖𝕘𝕦𝕣𝕒𝕤. 𝕃𝕒 𝕘𝕖𝕟𝕖𝕣𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕖𝕛𝕖𝕞𝕡𝕝𝕠𝕤 𝕕𝕖 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕤𝕖 𝕣𝕖𝕒𝕝𝕚𝕫𝕒 𝕤𝕚𝕟 𝕙𝕦𝕞𝕒𝕟𝕠𝕤, 𝕦𝕥𝕚𝕝𝕚𝕫𝕒𝕟𝕕𝕠 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕒𝕟𝕥𝕖𝕣𝕚𝕠𝕣 𝕡𝕒𝕣𝕒 𝕧𝕖𝕣𝕚𝕗𝕚𝕔𝕒𝕣 𝕝𝕒 𝕡𝕣𝕖𝕔𝕚𝕤𝕚𝕠́𝕟 𝕕𝕖 𝕝𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤. 𝔼𝕤𝕥𝕠 𝕞𝕖𝕛𝕠𝕣𝕒 𝕝𝕒 𝕖𝕗𝕚𝕔𝕒𝕔𝕚𝕒 𝕕𝕖𝕝 𝕒𝕡𝕣𝕖𝕟𝕕𝕚𝕫𝕒𝕛𝕖 𝕕𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠. 𝕃𝕒 𝕡𝕣𝕖𝕤𝕖𝕟𝕥𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕡𝕖𝕟𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤, 𝕔𝕠𝕞𝕠 𝕖𝕟 𝔻𝕖𝕖𝕡𝕤 ℝ𝟙, 𝕠𝕗𝕣𝕖𝕔𝕖 𝕥𝕣𝕒𝕟𝕤𝕡𝕒𝕣𝕖𝕟𝕔𝕚𝕒 𝕪 𝕔𝕠𝕟𝕗𝕚𝕒𝕟𝕫𝕒 𝕒𝕝 𝕦𝕤𝕦𝕒𝕣𝕚𝕠. 𝔼𝕤𝕥𝕖 𝕖𝕟𝕗𝕠𝕢𝕦𝕖 𝕙𝕒 𝕣𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕒𝕕𝕠 𝕝𝕒 𝕚𝕟𝕥𝕖𝕣𝕗𝕒𝕫 𝕘𝕣𝕒́𝕗𝕚𝕔𝕒 𝕖𝕟 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝.

𝔼𝕝 𝕔𝕣𝕖𝕔𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕕𝕖𝕡𝕖𝕟𝕕𝕖 𝕕𝕖 𝕝𝕒 𝕚𝕟𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕖𝕟 𝕔𝕙𝕚𝕡𝕤 𝕪 𝕡𝕣𝕠𝕔𝕖𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠, 𝕝𝕠 𝕢𝕦𝕖 𝕙𝕒 𝕝𝕝𝕖𝕧𝕒𝕕𝕠 𝕒 𝕦𝕟 𝕔𝕒𝕞𝕓𝕚𝕠 𝕖𝕟 𝕝𝕒 𝕗𝕠𝕣𝕞𝕒 𝕖𝕟 𝕢𝕦𝕖 𝕝𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕒𝕟 𝕤𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕖𝕤. 𝔼𝕤𝕥𝕠 𝕙𝕒 𝕣𝕖𝕕𝕦𝕔𝕚𝕕𝕠 𝕝𝕠𝕤 𝕔𝕠𝕤𝕥𝕠𝕤 𝕪 𝕥𝕣𝕒𝕟𝕤𝕗𝕠𝕣𝕞𝕒𝕕𝕠 𝕝𝕒 𝕔𝕦𝕝𝕥𝕦𝕣𝕒 𝕕𝕖𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕕𝕖 𝕤𝕠𝕗𝕥𝕨𝕒𝕣𝕖 𝕖𝕟 𝕝𝕒 𝕚𝕟𝕕𝕦𝕤𝕥𝕣𝕚𝕒. 𝔼𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 ℝ𝟙 𝕙𝕒 𝕣𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕒𝕕𝕠 𝕖𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝, 𝕕𝕖𝕞𝕠𝕤𝕥𝕣𝕒𝕟𝕕𝕠 𝕢𝕦𝕖 𝕖𝕤 𝕡𝕠𝕤𝕚𝕓𝕝𝕖 𝕠𝕓𝕥𝕖𝕟𝕖𝕣 𝕣𝕖𝕤𝕦𝕝𝕥𝕒𝕕𝕠𝕤 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒𝕥𝕚𝕧𝕠𝕤 𝕔𝕠𝕟 𝕞𝕖𝕟𝕠𝕤 𝕣𝕖𝕔𝕦𝕣𝕤𝕠𝕤. 𝔼𝕤𝕥𝕖 𝕒𝕧𝕒𝕟𝕔𝕖 𝕠𝕓𝕝𝕚𝕘𝕒 𝕒 𝕝𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕒 𝕣𝕖𝕔𝕠𝕟𝕤𝕚𝕕𝕖𝕣𝕒𝕣 𝕤𝕦𝕤 𝕖𝕟𝕗𝕠𝕢𝕦𝕖𝕤 𝕥𝕖𝕔𝕟𝕠𝕝𝕠́𝕘𝕚𝕔𝕠𝕤. 𝕃𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕖𝕤𝕥𝕒́𝕟 𝕚𝕟𝕧𝕚𝕣𝕥𝕚𝕖𝕟𝕕𝕠 𝕖𝕟 𝕔𝕙𝕚𝕡𝕤 𝕞𝕒́𝕤 𝕖𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖𝕤, 𝕝𝕠 𝕢𝕦𝕖 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕠𝕗𝕣𝕖𝕔𝕖𝕣 𝕤𝕖𝕣𝕧𝕚𝕔𝕚𝕠𝕤 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕒 𝕦𝕟 𝕔𝕠𝕤𝕥𝕠 𝕞𝕖𝕟𝕠𝕣.

𝕃𝕒𝕤 𝕟𝕦𝕖𝕧𝕒𝕤 𝕒𝕣𝕢𝕦𝕚𝕥𝕖𝕔𝕥𝕦𝕣𝕒𝕤 𝕕𝕖 ℂℙ𝕌 𝕪 𝔾ℙ𝕌 𝕖𝕤𝕥𝕒́𝕟 𝕣𝕖𝕧𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕒𝕟𝕕𝕠 𝕖𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝, 𝕓𝕖𝕟𝕖𝕗𝕚𝕔𝕚𝕒𝕟𝕕𝕠 𝕒 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕔𝕠𝕞𝕠 𝔸𝕡𝕡𝕝𝕖, 𝔸𝕄𝔻 𝕪 𝕄𝕖𝕥𝕒. 𝔼𝕤𝕥𝕠 𝕔𝕣𝕖𝕒 𝕠𝕡𝕠𝕣𝕥𝕦𝕟𝕚𝕕𝕒𝕕𝕖𝕤 𝕒𝕔𝕔𝕖𝕤𝕚𝕓𝕝𝕖𝕤 𝕡𝕒𝕣𝕒 𝕞𝕒́𝕤 𝕡𝕖𝕣𝕤𝕠𝕟𝕒𝕤 𝕖𝕟 𝕖𝕝 𝕔𝕒𝕞𝕡𝕠 𝕥𝕖𝕔𝕟𝕠𝕝𝕠́𝕘𝕚𝕔𝕠. 𝕃𝕒 𝕒𝕣𝕢𝕦𝕚𝕥𝕖𝕔𝕥𝕦𝕣𝕒 𝕕𝕖 𝔸𝕡𝕡𝕝𝕖, 𝕢𝕦𝕖 𝕚𝕟𝕔𝕝𝕦𝕪𝕖 𝕝𝕒 𝕔𝕠𝕞𝕡𝕒𝕣𝕥𝕚𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕖𝕟𝕥𝕣𝕖 ℂℙ𝕌 𝕪 𝔾ℙ𝕌, 𝕞𝕖𝕛𝕠𝕣𝕒 𝕖𝕝 𝕣𝕖𝕟𝕕𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕟 𝕥𝕒𝕣𝕖𝕒𝕤 𝕕𝕖 𝕄𝕒𝕔𝕙𝕚𝕟𝕖 𝕃𝕖𝕒𝕣𝕟𝕚𝕟𝕘. 𝔼𝕤𝕥𝕠 𝕡𝕠𝕤𝕚𝕔𝕚𝕠𝕟𝕒 𝕒 𝔸𝕡𝕡𝕝𝕖 𝕔𝕠𝕞𝕠 𝕦𝕟 𝕝𝕚́𝕕𝕖𝕣 𝕚𝕟𝕟𝕠𝕧𝕒𝕕𝕠𝕣 𝕖𝕟 𝕥𝕖𝕔𝕟𝕠𝕝𝕠𝕘𝕚́𝕒.

𝕃𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕔𝕠𝕞𝕠 𝔸𝕄𝔻 𝕖𝕤𝕥𝕒́𝕟 𝕣𝕠𝕞𝕡𝕚𝕖𝕟𝕕𝕠 𝕖𝕝 𝕞𝕠𝕟𝕠𝕡𝕠𝕝𝕚𝕠 𝕕𝕖 ℕ𝕧𝕚𝕕𝕚𝕒, 𝕡𝕖𝕣𝕞𝕚𝕥𝕚𝕖𝕟𝕕𝕠 𝕦𝕟 𝕒𝕔𝕔𝕖𝕤𝕠 𝕞𝕒́𝕤 𝕒𝕞𝕡𝕝𝕚𝕠 𝕪 𝕔𝕠𝕞𝕡𝕖𝕥𝕚𝕥𝕚𝕧𝕠 𝕒 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝. 𝔼𝕤𝕥𝕠 𝕕𝕖𝕞𝕠𝕔𝕣𝕒𝕥𝕚𝕫𝕒 𝕖𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕥𝕖𝕔𝕟𝕠𝕝𝕠́𝕘𝕚𝕔𝕠 𝕖𝕟𝕥𝕣𝕖 𝕕𝕚𝕤𝕥𝕚𝕟𝕥𝕠𝕤 𝕛𝕦𝕘𝕒𝕕𝕠𝕣𝕖𝕤 𝕕𝕖𝕝 𝕞𝕖𝕣𝕔𝕒𝕕𝕠. 𝔼𝕝 𝕤𝕦𝕣𝕘𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕒𝕓𝕚𝕖𝕣𝕥𝕠𝕤 𝕓𝕖𝕟𝕖𝕗𝕚𝕔𝕚𝕒 𝕒 𝕄𝕖𝕥𝕒 𝕪 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕦𝕟𝕒 𝕞𝕒𝕪𝕠𝕣 𝕕𝕚𝕤𝕥𝕣𝕚𝕓𝕦𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕔𝕠𝕟𝕥𝕖𝕟𝕚𝕕𝕠.

𝕐 𝕖𝕤𝕠 𝕥𝕒𝕞𝕓𝕚𝕖́𝕟 𝕖𝕤 𝕧𝕖𝕣𝕕𝕒𝕕 𝕡𝕒𝕣𝕒 𝕠𝕥𝕣𝕒𝕤 𝕔𝕠𝕞𝕡𝕒𝕟̃𝕚́𝕒𝕤. 𝕄𝕖𝕥𝕒, 𝕡𝕠𝕣 𝕖𝕛𝕖𝕞𝕡𝕝𝕠, 𝕝𝕠𝕤 𝕔𝕣𝕖𝕒𝕕𝕠𝕣𝕖𝕤 𝕕𝕖 𝔽𝕒𝕔𝕖𝕓𝕠𝕠𝕜, 𝕖𝕟𝕥𝕖𝕟𝕕𝕚́𝕒𝕟 𝕢𝕦𝕖 𝕥𝕒𝕞𝕓𝕚𝕖́𝕟 𝕖𝕤𝕥𝕒𝕓𝕒𝕟 𝕦𝕟 𝕡𝕠𝕢𝕦𝕚𝕥𝕠 𝕒𝕥𝕣𝕒́𝕤 𝕔𝕠𝕟 𝕤𝕦 𝕡𝕣𝕠𝕡𝕚𝕠 𝕞𝕠𝕕𝕖𝕝𝕠, 𝕃𝕝𝕒𝕞𝕒. 𝔼𝕝𝕝𝕠𝕤 𝕕𝕖𝕞𝕠𝕝𝕚𝕖𝕣𝕠𝕟 𝕦𝕟 𝕕𝕒𝕥𝕒𝕔𝕖𝕟𝕥𝕖𝕣 𝕖𝕟 𝟚𝟘𝟚𝟛 𝕢𝕦𝕖 𝕝𝕝𝕖𝕧𝕒𝕓𝕒𝕟 𝕪𝕒 𝕔𝕠𝕞𝕡𝕝𝕖𝕥𝕒𝕕𝕠 𝕙𝕒𝕤𝕥𝕒 𝕝𝕒 𝕞𝕚𝕥𝕒𝕕 𝕪 𝕝𝕠 𝕧𝕠𝕝𝕧𝕚𝕖𝕣𝕠𝕟 𝕒 𝕒𝕣𝕣𝕒𝕟𝕔𝕒𝕣 𝕕𝕖𝕤𝕕𝕖 𝕔𝕖𝕣𝕠 𝕡𝕒𝕣𝕒 𝕣𝕖𝕙𝕒𝕔𝕖𝕣𝕝𝕠 𝕔𝕠𝕟 𝕝𝕒 𝕒𝕣𝕢𝕦𝕚𝕥𝕖𝕔𝕥𝕦𝕣𝕒 𝕟𝕖𝕔𝕖𝕤𝕒𝕣𝕚𝕒 𝕡𝕒𝕣𝕒 𝕖𝕝 𝕗𝕦𝕥𝕦𝕣𝕠 𝕕𝕖 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝. ℍ𝕒𝕤𝕥𝕒 𝕢𝕦𝕖 𝕦𝕟 𝕕𝕚́𝕒 𝕦𝕟 𝕖𝕞𝕡𝕝𝕖𝕒𝕕𝕠 𝕕𝕖 𝕄𝕖𝕥𝕒 𝕗𝕚𝕝𝕥𝕣𝕒 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕃𝕝𝕒𝕞𝕒 𝕪 𝕗𝕦𝕖𝕣𝕫𝕒 𝕒 ℤ 𝕦𝕔𝕜𝕖𝕣𝕓𝕖𝕣𝕘 𝕒 𝕔𝕣𝕖𝕒𝕣 𝕦𝕟 𝕖𝕤𝕥𝕒́𝕟𝕕𝕒𝕣 𝕝𝕚𝕓𝕣𝕖 𝕕𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕪 𝕒 𝕝𝕚𝕓𝕖𝕣𝕒𝕣 𝕝𝕠𝕤 𝕡𝕖𝕤𝕠𝕤 𝕡𝕣𝕖𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕕𝕠𝕤 𝕤𝕚𝕟 𝕝𝕚𝕓𝕖𝕣𝕒𝕣 𝕝𝕠𝕤 𝕕𝕒𝕥𝕠𝕤 𝕕𝕖 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕒𝕝 𝕟𝕚𝕧𝕖𝕝 𝕕𝕖 𝔾ℙ𝕋-𝟚 𝕪 𝔾ℙ𝕋-𝟛. 𝔼𝕤𝕥𝕖 𝕤𝕖 𝕔𝕠𝕟𝕠𝕔𝕖 𝕔𝕠𝕞𝕠 𝕃𝕝𝕒𝕞𝕒, 𝕪 𝕃𝕝𝕒𝕞𝕒 𝕝𝕠 𝕔𝕒𝕞𝕓𝕚𝕠́ 𝕥𝕠𝕕𝕠. 𝕃𝕝𝕒𝕞𝕒 𝕖𝕣𝕒 𝕦𝕟𝕒 𝕡𝕖𝕢𝕦𝕖𝕟̃𝕒 𝕖𝕤𝕡𝕖𝕣𝕒𝕟𝕫𝕒 𝕡𝕒𝕣𝕒 𝕝𝕒𝕤 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤, 𝕪 𝕡𝕦𝕖𝕤 𝕦𝕤𝕥𝕖𝕕𝕖𝕤 𝕡𝕦𝕖𝕕𝕖𝕟 𝕔𝕠𝕣𝕣𝕖𝕣 𝕃𝕝𝕒𝕞𝕒 𝕖𝕟 𝕝𝕠𝕔𝕒𝕝 𝕤𝕚𝕟 𝕝𝕒 𝕞𝕖𝕟𝕠𝕣 𝕕𝕦𝕕𝕒.

ℙ𝕖𝕣𝕠 𝕝𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒𝕟𝕥𝕖 𝕕𝕖 𝕃𝕝𝕒𝕞𝕒 𝕟𝕠 𝕖𝕤 𝕖𝕤𝕠, 𝕤𝕚𝕟𝕠 𝕢𝕦𝕖 𝕞𝕠𝕤𝕥𝕣𝕠́ 𝕒𝕝 𝕞𝕦𝕟𝕕𝕠 𝕔𝕠́𝕞𝕠 𝕙𝕒𝕔𝕖𝕣 𝕖𝕤𝕥𝕠 𝕪 𝕒𝕙𝕠𝕣𝕒 𝕖𝕤𝕥𝕖 𝕖𝕢𝕦𝕚𝕡𝕠 𝕕𝕖 𝕔𝕙𝕚𝕟𝕠𝕤 𝕔𝕣𝕖𝕠́ 𝔻𝕖𝕖𝕡𝕊𝕖𝕖𝕜 ℝ𝟙, 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕢𝕦𝕖 𝕪𝕠 𝕥𝕖𝕟𝕘𝕠 𝕪𝕒 𝕔𝕠𝕣𝕣𝕚𝕖𝕟𝕕𝕠 𝕖𝕟 𝕞𝕚 𝕝𝕒𝕡𝕥𝕠𝕡. 𝔼𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕟𝕠 𝕤𝕠𝕝𝕒𝕞𝕖𝕟𝕥𝕖 𝕖𝕤 𝕚𝕟𝕔𝕣𝕖𝕚́𝕓𝕝𝕖, 𝕤𝕚𝕟𝕠 𝕢𝕦𝕖 𝕝𝕠 𝕕𝕖𝕤𝕥𝕚𝕝𝕒𝕣𝕠𝕟. 𝔻𝕖𝕤𝕥𝕚𝕝𝕒𝕣 𝕖𝕤 𝕦𝕟 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕖𝕟 𝕖𝕝 𝕢𝕦𝕖 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕘𝕣𝕒𝕟𝕕𝕠𝕥𝕖 𝕒𝕔𝕥𝕦́𝕒 𝕔𝕠𝕞𝕠 𝕡𝕣𝕠𝕗𝕖𝕤𝕠𝕣 𝕪 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕔𝕙𝕚𝕢𝕦𝕚𝕥𝕠𝕤 𝕔𝕠𝕞𝕠 𝕖𝕤𝕥𝕦𝕕𝕚𝕒𝕟𝕥𝕖𝕤. 𝕐 𝕡𝕒𝕣𝕒 𝕟𝕠 𝕙𝕒𝕔𝕖𝕣𝕝𝕠 𝕞𝕦𝕪 𝕔𝕠𝕞𝕡𝕝𝕚𝕔𝕒𝕕𝕠, 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕔𝕣𝕖𝕒𝕣 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕞𝕒́𝕤 𝕡𝕖𝕢𝕦𝕖𝕟̃𝕠𝕤, 𝕔𝕒𝕤𝕚 𝕥𝕒𝕟 𝕓𝕦𝕖𝕟𝕠𝕤 𝕔𝕠𝕞𝕠 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕘𝕣𝕒𝕟𝕕𝕖 𝕡𝕖𝕣𝕠 𝕤𝕚𝕖𝕟𝕕𝕠 𝕞𝕦𝕔𝕙𝕠 𝕞𝕒́𝕤 𝕧𝕖𝕝𝕠𝕔𝕖𝕤. 𝕐𝕠 𝕖𝕤𝕥𝕦𝕧𝕖 𝕡𝕣𝕠𝕓𝕒𝕟𝕕𝕠 ℝ𝟙 𝕖𝕟 𝕝𝕒 𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕧𝕖𝕝𝕠𝕫 𝕖𝕟 𝕤𝕖𝕣𝕧𝕚𝕕𝕠𝕣𝕖𝕤 𝕡𝕣𝕠𝕡𝕚𝕠𝕤, 𝕝𝕒 𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕔𝕠𝕞𝕡𝕒𝕔𝕥𝕒, 𝕪 𝕖𝕤 𝕚𝕞𝕡𝕣𝕖𝕤𝕚𝕠𝕟𝕒𝕟𝕥𝕖. 𝔼𝕤 𝕓𝕒́𝕤𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖 𝕕𝕖𝕝 𝕟𝕚𝕧𝕖𝕝 𝕕𝕖 𝔾ℙ𝕋-𝟜 𝕠 𝕕𝕚𝕣𝕚́𝕒 𝕪𝕠 𝕢𝕦𝕖 𝕞𝕖𝕛𝕠𝕣, 𝕖𝕤 𝕕𝕖𝕝 𝕟𝕚𝕧𝕖𝕝 𝕕𝕖 𝔾ℙ𝕋-𝟜 𝕞𝕚𝕟𝕚, 𝕠 𝕤𝕖𝕒, 𝕤𝕖 𝕞𝕦𝕖𝕧𝕖 𝕤𝕦𝕡𝕖𝕣𝕣𝕒́𝕡𝕚𝕕𝕠.

ℝ𝟙 𝕖𝕤 𝕥𝕒𝕟 𝕓𝕦𝕖𝕟𝕠 𝕢𝕦𝕖 𝕖𝕝 𝕖𝕢𝕦𝕚𝕡𝕠 𝕕𝕖 𝕎𝕖𝕓𝔸𝕤𝕤𝕖𝕞𝕓𝕝𝕪, 𝕖𝕝 𝕖𝕢𝕦𝕚𝕡𝕠 𝕢𝕦𝕖 𝕤𝕖 𝕖𝕟𝕔𝕒𝕣𝕘𝕒 𝕕𝕖 𝕢𝕦𝕖 𝕎𝕖𝕓𝔸𝕤𝕤𝕖𝕞𝕓𝕝𝕪, 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕕𝕖 𝕞𝕒́𝕢𝕦𝕚𝕟𝕒, 𝕔𝕠𝕣𝕣𝕒 𝕖𝕟 𝕖𝕝 𝕟𝕒𝕧𝕖𝕘𝕒𝕕𝕠𝕣, 𝕒𝕘𝕒𝕣𝕣𝕠́ 𝕦𝕟 𝕞𝕠́𝕕𝕦𝕝𝕠 𝕙𝕖𝕔𝕙𝕠 𝕖𝕟 ℂ++ 𝕪 𝕝𝕠 𝕡𝕒𝕤𝕠́ 𝕡𝕠𝕣 ℝ𝟙, 𝕪 𝕝𝕠𝕘𝕣𝕒𝕣𝕠𝕟 𝕣𝕖𝕖𝕤𝕔𝕣𝕚𝕓𝕚𝕣𝕝𝕠 𝕡𝕒𝕣𝕒 𝕦𝕤𝕒𝕣 𝕝𝕒𝕤 𝕚𝕟𝕤𝕥𝕣𝕦𝕔𝕔𝕚𝕠𝕟𝕖𝕤 𝕕𝕖 ℂℙ𝕌 𝕟𝕒𝕥𝕚𝕧𝕒𝕤 𝕕𝕖 𝕝𝕠𝕤 𝕔𝕙𝕚𝕡𝕤. 𝕃𝕒𝕤 𝕚𝕟𝕤𝕥𝕣𝕦𝕔𝕔𝕚𝕠𝕟𝕖𝕤 𝕤𝕖 𝕝𝕝𝕒𝕞𝕒𝕟 𝕊𝕀𝕄𝔻. 𝔼𝕝 𝟡𝟡% 𝕕𝕖𝕝 𝕔𝕠́𝕕𝕚𝕘𝕠 𝕝𝕠 𝕖𝕤𝕔𝕣𝕚𝕓𝕚𝕠́ ℝ𝟙, 𝕪 𝕖𝕝 𝕣𝕖𝕡𝕠 𝕖𝕤𝕥𝕒́ 𝕒𝕓𝕚𝕖𝕣𝕥𝕠 𝕪 𝕕𝕚𝕤𝕡𝕠𝕟𝕚𝕓𝕝𝕖 𝕒𝕝 𝕡𝕦́𝕓𝕝𝕚𝕔𝕠. 𝔹𝕦́𝕤𝕢𝕦𝕖𝕟𝕝𝕠, 𝕘𝕠𝕠𝕘𝕝𝕖𝕖𝕟𝕝𝕠 𝕪 𝕧𝕒𝕟 𝕒 𝕖𝕟𝕔𝕠𝕟𝕥𝕣𝕒𝕣𝕝𝕠. 𝕄𝕚𝕣𝕖𝕟 ℝ𝟙 𝕕𝕖 𝔹ℙ𝕊ℂ, 𝕔𝕒𝕤𝕚 𝕤𝕖𝕘𝕦𝕣𝕠 𝕢𝕦𝕖 𝕖𝕤 𝕡𝕣𝕠𝕕𝕦𝕔𝕥𝕠 𝕕𝕖 𝕦𝕟 𝕕𝕒𝕥𝕒 𝕔𝕖𝕟𝕥𝕖𝕣 𝕔𝕝𝕒𝕟𝕕𝕖𝕤𝕥𝕚𝕟𝕠 𝕔𝕙𝕚𝕟𝕠, 𝕡𝕠𝕣𝕢𝕦𝕖 𝔼𝕤𝕥𝕒𝕕𝕠𝕤 𝕌𝕟𝕚𝕕𝕠𝕤 𝕚𝕞𝕡𝕚𝕕𝕖 𝕖𝕝 𝕖𝕟𝕧𝕚́𝕠 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 ℍ𝟙𝟘𝟘 𝕒 ℂ𝕙𝕚𝕟𝕒, 𝕝𝕠𝕤 𝕔𝕙𝕚𝕡𝕤 𝕞𝕒́𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕠𝕤 𝕕𝕖 ℕ𝕧𝕚𝕕𝕚𝕒. ℙ𝕖𝕣𝕠 ℂ𝕙𝕚𝕟𝕒 𝕥𝕚𝕖𝕟𝕖 𝕦𝕟 𝕞𝕠𝕟𝕥𝕠́𝕟 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 ℍ𝟠𝟘𝟘. 𝔼𝕝 𝕣𝕦𝕞𝕠𝕣 𝕖𝕤 𝕢𝕦𝕖 𝕥𝕚𝕖𝕟𝕖𝕟 𝕦𝕟 𝕔𝕝𝕦́𝕤𝕥𝕖𝕣 𝕕𝕖 𝟝𝟘,𝟘𝟘𝟘 𝕔𝕙𝕚𝕡𝕤 ℍ𝟞𝟘𝟘. ℙ𝕒𝕣𝕒 𝕢𝕦𝕖 𝕤𝕖 𝕙𝕒𝕘𝕒𝕟 𝕦𝕟𝕒 𝕚𝕕𝕖𝕒, 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕔𝕠𝕞𝕠 𝕄𝕚𝕔𝕣𝕠𝕤𝕠𝕗𝕥 𝕥𝕚𝕖𝕟𝕖𝕟 𝕞𝕖𝕕𝕚𝕠 𝕞𝕚𝕝𝕝𝕠́𝕟 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 ℍ𝟙𝟘𝟘, 𝕢𝕦𝕖 𝕤𝕠𝕟 𝕝𝕠𝕤 𝕞𝕒́𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕠𝕤. ℙ𝕖𝕣𝕠 𝕖𝕤𝕠 𝕟𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒, 𝕢𝕦𝕖 𝕤𝕚 𝕔𝕠𝕤𝕥𝕠́ 𝟝 𝕞𝕚𝕝𝕝𝕠𝕟𝕖𝕤 𝕕𝕖 𝕕𝕠́𝕝𝕒𝕣𝕖𝕤, 𝕖𝕤𝕠 𝕟𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒. 𝕄𝕦𝕪 𝕡𝕣𝕠𝕓𝕒𝕓𝕝𝕖𝕞𝕖𝕟𝕥𝕖 𝕖𝕤 𝕞𝕖𝕟𝕥𝕚𝕣𝕒 𝕢𝕦𝕖 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝔻𝕚𝕡𝕤 ℝ𝟙 𝕔𝕠𝕤𝕥𝕠́ 𝟝 𝕞𝕚𝕝𝕝𝕠𝕟𝕖𝕤 𝕕𝕖 𝕕𝕠́𝕝𝕒𝕣𝕖𝕤 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕣, 𝕟𝕒𝕕𝕒 𝕕𝕖 𝕖𝕤𝕠 𝕖𝕤 𝕝𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒𝕟𝕥𝕖. 𝔸𝕙𝕚́ 𝕟𝕠 𝕖𝕤𝕥𝕒́𝕟 𝕖𝕟𝕥𝕖𝕟𝕕𝕚𝕖𝕟𝕕𝕠 𝕝𝕠 𝕢𝕦𝕖 𝕣𝕖𝕒𝕝𝕞𝕖𝕟𝕥𝕖 𝕖𝕤 𝕚𝕞𝕡𝕠𝕣𝕥𝕒𝕟𝕥𝕖.

ℝ𝟙 𝕤𝕖 𝕡𝕦𝕖𝕕𝕖 𝕣𝕖𝕡𝕝𝕚𝕔𝕒𝕣. ℍ𝕦𝕘𝕘𝕚𝕟𝕘 𝔽𝕒𝕔𝕖, 𝕖𝕝 𝕖𝕢𝕦𝕚𝕡𝕠 𝕕𝕖 ℍ𝕦𝕘𝕘𝕚𝕟𝕘 𝔽𝕒𝕔𝕖, 𝕡𝕣𝕠𝕓𝕒𝕓𝕝𝕖𝕞𝕖𝕟𝕥𝕖 𝕝𝕠𝕤 𝕝𝕚́𝕕𝕖𝕣𝕖𝕤 𝕖𝕟 𝕕𝕚𝕤𝕡𝕠𝕟𝕖𝕣 𝕕𝕖 𝕞𝕒𝕟𝕖𝕣𝕒 𝕒𝕓𝕚𝕖𝕣𝕥𝕒 𝕔𝕠𝕤𝕒𝕤 𝕔𝕠𝕞𝕠 ℝ𝟙 𝕒𝕝 𝕞𝕦𝕟𝕕𝕠, 𝕖𝕤𝕥𝕒́𝕟 𝕖𝕟 𝕖𝕤𝕥𝕖 𝕞𝕠𝕞𝕖𝕟𝕥𝕠 𝕙𝕒𝕔𝕚𝕖𝕟𝕕𝕠 𝕦𝕟 𝕡𝕣𝕠𝕪𝕖𝕔𝕥𝕠 𝕡𝕒𝕣𝕒 𝕣𝕖𝕡𝕝𝕚𝕔𝕒𝕣 𝕖𝕝 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕢𝕦𝕖 𝕙𝕚𝕔𝕚𝕖𝕣𝕠𝕟 𝕖𝕟 ℝ𝟙, 𝕝𝕒 𝕘𝕖𝕟𝕥𝕖 𝕕𝕖 𝕝𝕒 𝕖𝕞𝕡𝕣𝕖𝕤𝕒 𝕢𝕦𝕖 𝕔𝕣𝕖𝕠́ 𝔻𝕚𝕡𝕤𝕪, 𝕪 𝕕𝕖 𝕖𝕤𝕒 𝕞𝕒𝕟𝕖𝕣𝕒 𝕔𝕠𝕟𝕗𝕚𝕣𝕞𝕒𝕣 𝕢𝕦𝕖 𝕤𝕖 𝕡𝕦𝕖𝕕𝕖. 𝔼𝕝 𝕞𝕚𝕤𝕞𝕠 𝕖𝕢𝕦𝕚𝕡𝕠 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕀 𝕪𝕒 𝕒𝕟𝕦𝕟𝕔𝕚𝕠́ 𝕢𝕦𝕖 𝕝𝕖𝕪𝕖𝕟𝕕𝕠 𝕖𝕝 𝕡𝕒𝕡𝕖𝕣 𝕕𝕖 𝔻𝕚𝕡𝕤 ℝ𝟙 𝕖𝕟𝕔𝕠𝕟𝕥𝕣𝕒𝕣𝕠𝕟 𝕢𝕦𝕖 𝕝𝕒 𝕖𝕞𝕡𝕣𝕖𝕤𝕒 𝕝𝕠𝕘𝕣𝕠́ 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕒𝕣 𝕧𝕒𝕣𝕚𝕒𝕤 𝕕𝕖 𝕝𝕒𝕤 𝕚𝕟𝕟𝕠𝕧𝕒𝕔𝕚𝕠𝕟𝕖𝕤 𝕢𝕦𝕖 𝕖𝕝 𝕞𝕚𝕤𝕞𝕠 𝕖𝕢𝕦𝕚𝕡𝕠 𝕡𝕖𝕟𝕤𝕠́ 𝕡𝕒𝕣𝕒 𝔾ℙ𝕋-𝟜. ℝ𝟙, 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 ℂ𝕙𝕚𝕟𝕒, 𝕖𝕤 𝟙.𝟝 𝕠́𝕣𝕕𝕖𝕟𝕖𝕤 𝕕𝕖 𝕞𝕒𝕘𝕟𝕚𝕥𝕦𝕕 𝕞𝕒́𝕤 𝕖𝕔𝕠𝕟𝕠́𝕞𝕚𝕔𝕠𝕤 𝕢𝕦𝕖 𝔾ℙ𝕋-𝟜, 𝕔𝕠𝕟 𝕦𝕟𝕒 𝕔𝕒𝕡𝕒𝕔𝕚𝕕𝕒𝕕 𝕕𝕖 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕞𝕦𝕪, 𝕞𝕦𝕪, 𝕞𝕦𝕪 𝕤𝕚𝕞𝕚𝕝𝕒𝕣. 𝕃𝕠 𝕔𝕦𝕒𝕝, 𝕡𝕦𝕖𝕤, 𝕖𝕤 𝕚𝕞𝕡𝕣𝕖𝕤𝕚𝕠𝕟𝕒𝕟𝕥𝕖 𝕡𝕠𝕣𝕢𝕦𝕖 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒 𝕢𝕦𝕖 𝕖𝕝 𝕔𝕠𝕤𝕥𝕠 𝕕𝕖 𝕚𝕟𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒 𝕧𝕒 𝕒 𝕓𝕒𝕛𝕒𝕣. 𝕐 𝕖𝕟𝕥𝕠𝕟𝕔𝕖𝕤 𝕥𝕠𝕕𝕒𝕤 𝕝𝕒𝕤 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤, 𝕥𝕠𝕕𝕒𝕤 𝕝𝕒𝕤 𝕤𝕥𝕒𝕣𝕥𝕦𝕡𝕤 𝕥𝕖𝕟𝕖𝕞𝕠𝕤 𝕒𝕔𝕔𝕖𝕤𝕠 𝕒 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕗𝕣𝕠𝕟𝕥𝕖𝕣𝕒 𝕔𝕠𝕞𝕠 𝔾ℙ𝕋-𝟜 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕀 𝕤𝕚𝕟 𝕚𝕟𝕧𝕖𝕣𝕥𝕚𝕣 𝕝𝕠𝕤 𝕞𝕚𝕝𝕝𝕠𝕟𝕖𝕤 𝕕𝕖 𝕕𝕠́𝕝𝕒𝕣𝕖𝕤 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕀.

𝔸 𝕔𝕠𝕟𝕥𝕚𝕟𝕦𝕒𝕔𝕚𝕠́𝕟 𝕧𝕚𝕖𝕟𝕖 𝕦𝕟𝕒 𝕖𝕩𝕡𝕝𝕚𝕔𝕒𝕔𝕚𝕠́𝕟 𝕓𝕚𝕖𝕟 𝕟𝕖𝕣𝕕 𝕪 𝕕𝕖 𝕚𝕟𝕘𝕖𝕟𝕚𝕖𝕣𝕚́𝕒 𝕕𝕖 ℝ𝟙. 𝔹𝕦𝕖𝕟𝕠, 𝕟𝕠 𝕥𝕒𝕟 𝕟𝕖𝕣𝕕, 𝕪𝕠 𝕥𝕖𝕟𝕘𝕠 𝕞𝕚𝕤 𝕝𝕚́𝕞𝕚𝕥𝕖𝕤 𝕪 𝕪𝕠 𝕟𝕠 𝕤𝕖́ 𝕥𝕒𝕟𝕥𝕠, 𝕡𝕖𝕣𝕠 𝕧𝕠𝕪 𝕒 𝕙𝕒𝕔𝕖𝕣 𝕞𝕚 𝕞𝕖𝕛𝕠𝕣 𝕖𝕤𝕗𝕦𝕖𝕣𝕫𝕠. ℝ𝟙 𝕥𝕚𝕖𝕟𝕖 𝕞𝕦𝕔𝕙𝕒𝕤 𝕔𝕠𝕤𝕒𝕤 𝕓𝕣𝕚𝕝𝕝𝕒𝕟𝕥𝕖𝕤. ℙ𝕠𝕣 𝕖𝕛𝕖𝕞𝕡𝕝𝕠, 𝕖𝕟 𝕧𝕖𝕫 𝕕𝕖 𝕦𝕤𝕒𝕣 𝕕𝕖𝕔𝕚𝕞𝕒𝕝𝕖𝕤 𝕕𝕖 𝕡𝕦𝕟𝕥𝕠 𝕗𝕝𝕠𝕥𝕒𝕟𝕥𝕖 𝕕𝕖 𝟙𝟞 𝕓𝕚𝕥𝕤, 𝕖𝕤𝕥𝕒́𝕟 𝕦𝕤𝕒𝕟𝕕𝕠 𝕕𝕖𝕔𝕚𝕞𝕒𝕝𝕖𝕤 𝕕𝕖 𝕡𝕦𝕟𝕥𝕠 𝕗𝕝𝕠𝕥𝕒𝕟𝕥𝕖 𝕕𝕖 𝟠 𝕓𝕚𝕥𝕤. 𝔼𝕤𝕠 𝕓𝕒́𝕤𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒 𝕢𝕦𝕖 𝕖𝕟 𝕝𝕒 𝕣𝕖𝕕 𝕟𝕖𝕦𝕣𝕠𝕟𝕒𝕝 𝕝𝕠𝕤 𝕟𝕦́𝕞𝕖𝕣𝕠𝕤 𝕢𝕦𝕖 𝕒𝕟𝕥𝕖𝕤 𝕥𝕖𝕟𝕚́𝕒𝕟 𝕦𝕟𝕒 𝕡𝕣𝕖𝕔𝕚𝕤𝕚𝕠́𝕟 𝕕𝕖 𝕦𝕟 𝕞𝕠𝕟𝕥𝕠́𝕟 𝕕𝕖 𝕕𝕖𝕔𝕚𝕞𝕒𝕝𝕖𝕤 𝕒𝕙𝕠𝕣𝕒 𝕥𝕚𝕖𝕟𝕖𝕟 𝕝𝕒 𝕞𝕚𝕥𝕒𝕕. 𝕐 𝕖𝕤𝕠 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒 𝕢𝕦𝕖 𝕦𝕤𝕒𝕟 𝕞𝕖𝕟𝕠𝕤 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕪 𝕞𝕖𝕟𝕠𝕤 𝕔𝕒𝕡𝕒𝕔𝕚𝕕𝕒𝕕 𝕕𝕖 𝕔𝕠́𝕞𝕡𝕦𝕥𝕠, 𝕝𝕠 𝕢𝕦𝕖 𝕝𝕠𝕤 𝕙𝕒𝕔𝕖 𝕞𝕒́𝕤 𝕧𝕖𝕝𝕠𝕔𝕖𝕤. 𝕋𝕒𝕞𝕓𝕚𝕖́𝕟 𝕖𝕤𝕥𝕒́𝕟 𝕦𝕤𝕒𝕟𝕕𝕠 𝕦𝕟𝕒 𝕥𝕖́𝕔𝕟𝕚𝕔𝕒 𝕕𝕖 𝕔𝕚𝕖𝕟𝕔𝕚𝕒𝕤 𝕕𝕖 𝕝𝕒 𝕔𝕠𝕞𝕡𝕦𝕥𝕒𝕔𝕚𝕠́𝕟 𝕢𝕦𝕖 𝕤𝕖 𝕝𝕝𝕒𝕞𝕒 𝕔𝕠𝕣𝕣𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕓𝕚𝕥𝕤. ℂ𝕦𝕒𝕟𝕕𝕠 𝕦𝕟𝕠 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒, 𝕦𝕟𝕠 𝕤𝕠𝕝𝕒𝕞𝕖𝕟𝕥𝕖 𝕡𝕚𝕖𝕟𝕤𝕒 𝕖𝕟 𝕓𝕪𝕥𝕖𝕤 𝕡𝕠𝕣𝕢𝕦𝕖 𝕖𝕤 𝕞𝕒́𝕤 𝕡𝕣𝕒́𝕔𝕥𝕚𝕔𝕠, 𝕡𝕖𝕣𝕠 𝕤𝕖 𝕡𝕦𝕖𝕕𝕖𝕟 𝕞𝕠𝕧𝕖𝕣 𝕓𝕚𝕥 𝕡𝕠𝕣 𝕓𝕚𝕥, 𝕔𝕒𝕕𝕒 𝕦𝕟𝕠 𝕕𝕖 𝕝𝕠𝕤 𝕓𝕚𝕥𝕤 𝕕𝕖 𝕝𝕒𝕤 𝕧𝕒𝕣𝕚𝕒𝕓𝕝𝕖𝕤 𝕪 𝕕𝕖 𝕝𝕠𝕤 𝕞𝕖𝕟𝕤𝕒𝕛𝕖𝕤 𝕢𝕦𝕖 𝕝𝕖 𝕖𝕟𝕧𝕚𝕒𝕞𝕠𝕤 𝕒 𝕝𝕒 ℂℙ𝕌. 𝔼𝕟 ℂ, 𝕖𝕤 𝕞𝕒́𝕤, 𝕡𝕠𝕣 𝕖𝕛𝕖𝕞𝕡𝕝𝕠, 𝕖𝕝 𝕤𝕚𝕘𝕟𝕠 𝕕𝕠𝕓𝕝𝕖 𝕞𝕒𝕪𝕠𝕣 𝕢𝕦𝕖 𝕠 𝕕𝕠𝕓𝕝𝕖 𝕞𝕖𝕟𝕠𝕣 𝕢𝕦𝕖 𝕖𝕤 𝕦𝕟 𝕤𝕚𝕘𝕟𝕠 𝕢𝕦𝕖 𝕟𝕠𝕤 𝕡𝕖𝕣𝕞𝕚𝕥𝕖 𝕙𝕒𝕔𝕖𝕣 𝕔𝕠𝕣𝕣𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕓𝕚𝕥𝕤. 𝔼𝕤𝕥𝕠 𝕖𝕤 𝕗𝕦𝕟𝕕𝕒𝕞𝕖𝕟𝕥𝕒𝕝, 𝕡𝕠𝕣 𝕖𝕛𝕖𝕞𝕡𝕝𝕠, 𝕖𝕟 𝕝𝕠𝕤 𝕒𝕝𝕘𝕠𝕣𝕚𝕥𝕞𝕠𝕤 𝕕𝕖 𝕔𝕠𝕞𝕡𝕣𝕖𝕤𝕚𝕠́𝕟, 𝕖𝕟 𝕝𝕠𝕤 𝕔𝕠𝕕𝕖𝕔𝕤, 𝕪 𝕒𝕙𝕠𝕣𝕒 𝕖𝕤 𝕗𝕦𝕟𝕕𝕒𝕞𝕖𝕟𝕥𝕒𝕝 𝕖𝕟 𝔸𝕀. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕥𝕠 𝕙𝕒𝕔𝕖 𝕢𝕦𝕖 𝕤𝕖 𝕦𝕤𝕖 𝕞𝕖𝕟𝕠𝕤 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 ℝ𝔸𝕄 𝕪 𝕢𝕦𝕖 𝕤𝕖 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕖 𝕞𝕖𝕟𝕠𝕤 𝕔𝕒𝕡𝕒𝕔𝕚𝕕𝕒𝕕 𝕕𝕖 𝕡𝕣𝕠𝕔𝕖𝕤𝕒𝕕𝕠𝕣. ℍ𝕒𝕪 𝕠𝕥𝕣𝕒𝕤 𝕔𝕠𝕤𝕒𝕤 𝕢𝕦𝕖 𝕙𝕚𝕔𝕚𝕖𝕣𝕠𝕟, 𝕔𝕠𝕞𝕠 𝕔𝕒𝕔𝕙𝕖𝕒𝕣 𝕝𝕒 𝕔𝕠𝕞𝕡𝕦𝕥𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕝𝕒 𝕒𝕥𝕖𝕟𝕔𝕚𝕠́𝕟, 𝕢𝕦𝕖 𝕖𝕤 𝕖𝕝 𝕤𝕚𝕤𝕥𝕖𝕞𝕒 𝕔𝕠𝕟𝕤𝕚𝕕𝕖𝕣𝕒𝕓𝕝𝕖 𝕔𝕠𝕟 𝕖𝕝 𝕢𝕦𝕖 𝕗𝕦𝕟𝕔𝕚𝕠𝕟𝕒𝕟 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕞𝕠𝕕𝕖𝕣𝕟𝕠𝕤 𝕓𝕒𝕤𝕒𝕕𝕠𝕤 𝕖𝕟 𝔾ℙ𝕋.

𝕆𝕥𝕣𝕒 𝕔𝕠𝕤𝕒 𝕞𝕦𝕪 𝕝𝕠𝕔𝕒 𝕖𝕤 𝕢𝕦𝕖 𝕠𝕡𝕥𝕚𝕞𝕚𝕫𝕒𝕣𝕠𝕟 𝕖𝕝 𝕔𝕠́𝕕𝕚𝕘𝕠 𝕖𝕤𝕡𝕖𝕔𝕚́𝕗𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖 𝕡𝕒𝕣𝕒 𝕖𝕝 𝕔𝕙𝕚𝕡 ℍ𝟠𝟘𝟘, 𝕢𝕦𝕖 𝕥𝕚𝕖𝕟𝕖 𝕦𝕟𝕒𝕤 𝕝𝕚𝕞𝕚𝕥𝕒𝕔𝕚𝕠𝕟𝕖𝕤 𝕕𝕖 𝕞𝕖𝕞𝕠𝕣𝕚𝕒, 𝕪 𝕖𝕟 𝕧𝕖𝕫 𝕕𝕖 𝕦𝕤𝕒𝕣 ℂ𝕌𝔻𝔸 (ℂ𝕌𝔻𝔸 𝕖𝕤 𝕔𝕠𝕞𝕠 𝕖𝕝 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕢𝕦𝕖 𝕦𝕤𝕒 ℕ𝕧𝕚𝕕𝕚𝕒 𝕡𝕒𝕣𝕒 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕣 𝕕𝕚𝕣𝕖𝕔𝕥𝕒𝕞𝕖𝕟𝕥𝕖 𝕖𝕝 𝕔𝕠́𝕕𝕚𝕘𝕠 𝕕𝕖 𝕞𝕒́𝕢𝕦𝕚𝕟𝕒), 𝕤𝕖 𝕗𝕦𝕖𝕣𝕠𝕟 𝕒 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕣 𝕕𝕚𝕣𝕖𝕔𝕥𝕒𝕞𝕖𝕟𝕥𝕖 𝕖𝕟 𝕒𝕤𝕤𝕖𝕞𝕓𝕝𝕖𝕣. ℙ𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕣𝕠𝕟 𝕖𝕝 𝕞𝕖𝕥𝕒𝕝 𝕔𝕠𝕞𝕠 𝕦𝕟𝕠 𝕝𝕠 𝕙𝕒𝕔𝕖 𝕔𝕦𝕒𝕟𝕕𝕠 𝕖𝕤𝕥𝕒́ 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕟𝕕𝕠 𝕦𝕟 𝕤𝕒𝕥𝕖́𝕝𝕚𝕥𝕖 𝕠 𝕦𝕟 𝕞𝕚𝕤𝕚𝕝, 𝕔𝕠𝕞𝕠 𝕤𝕖 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕓𝕒𝕟 𝕝𝕒𝕤 𝕔𝕠𝕞𝕡𝕦𝕥𝕒𝕕𝕠𝕣𝕒𝕤 𝕒𝕟𝕥𝕖𝕤. 𝔻𝕖 𝕖𝕤𝕒 𝕞𝕒𝕟𝕖𝕣𝕒, 𝕤𝕒𝕝𝕥𝕒𝕣𝕠𝕟 𝕞𝕦𝕔𝕙𝕒𝕤 𝕕𝕖 𝕝𝕒𝕤 𝕣𝕖𝕤𝕥𝕣𝕚𝕔𝕔𝕚𝕠𝕟𝕖𝕤 𝕪 𝕞𝕒𝕩𝕚𝕞𝕚𝕫𝕒𝕣𝕠𝕟 𝕖𝕝 𝕦𝕤𝕠 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 𝕚𝕟𝕗𝕖𝕣𝕚𝕠𝕣𝕖𝕤 𝕕𝕖𝕓𝕚𝕕𝕠 𝕒 𝕝𝕒 𝕣𝕖𝕤𝕥𝕣𝕚𝕔𝕔𝕚𝕠́𝕟 𝕢𝕦𝕖 𝕥𝕚𝕖𝕟𝕖 𝔼𝕤𝕥𝕒𝕕𝕠𝕤 𝕌𝕟𝕚𝕕𝕠𝕤 𝕕𝕖 𝕖𝕩𝕡𝕠𝕣𝕥𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 𝕒 ℂ𝕙𝕚𝕟𝕒. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕥𝕠 𝕕𝕖 𝕡𝕠𝕣 𝕤𝕚́ 𝕙𝕒𝕔𝕖 𝕢𝕦𝕖 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕔𝕠𝕣𝕣𝕒 𝕞𝕦𝕔𝕙𝕠 𝕞𝕒́𝕤 𝕣𝕒́𝕡𝕚𝕕𝕠 𝕔𝕠𝕟 𝕞𝕦𝕔𝕙𝕠𝕤 𝕞𝕖𝕟𝕠𝕤 𝕣𝕖𝕔𝕦𝕣𝕤𝕠𝕤. ℙ𝕖𝕣𝕠 𝕥𝕒𝕞𝕓𝕚𝕖́𝕟 𝕔𝕒𝕞𝕓𝕚𝕒𝕣𝕠𝕟 𝕝𝕒 𝕖𝕤𝕥𝕣𝕒𝕥𝕖𝕘𝕚𝕒 𝕖𝕟 𝕝𝕒 𝕢𝕦𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕟 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠. ℙ𝕒𝕣𝕒 𝕢𝕦𝕖 𝕖𝕟𝕥𝕖𝕟𝕕𝕒𝕞𝕠𝕤 𝕣𝕒́𝕡𝕚𝕕𝕠 𝕔𝕠́𝕞𝕠 𝕤𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠, 𝕥𝕖𝕟𝕖𝕞𝕠𝕤 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕓𝕒𝕤𝕖 𝕢𝕦𝕖 𝕤𝕠𝕟 𝕥𝕠𝕕𝕠𝕤 𝕝𝕠𝕤 𝕥𝕣𝕒𝕟𝕤𝕗𝕠𝕣𝕞𝕒𝕕𝕠𝕣𝕖𝕤. 𝔼𝕤 𝕒𝕘𝕒𝕣𝕣𝕒𝕣 𝕥𝕠𝕕𝕠 𝕖𝕝 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕕𝕖 𝕝𝕒 𝕔𝕦𝕝𝕥𝕦𝕣𝕒 𝕙𝕦𝕞𝕒𝕟𝕒 𝕪 𝕖𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕒𝕣𝕝𝕠 𝕖𝕟 𝕦𝕟𝕒 𝕞𝕒𝕥𝕣𝕚𝕫 𝕢𝕦𝕖 𝕘𝕖𝕟𝕖𝕣𝕒 𝕥𝕠𝕕𝕒 𝕝𝕒 𝕣𝕖𝕕 𝕕𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕒𝕥𝕖𝕟𝕔𝕚𝕠́𝕟 𝕡𝕒𝕣𝕒 𝕝𝕦𝕖𝕘𝕠 𝕡𝕣𝕖𝕕𝕖𝕔𝕚𝕣 𝕖𝕤𝕥𝕒𝕕𝕚́𝕤𝕥𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖 𝕝𝕒 𝕤𝕚𝕘𝕦𝕚𝕖𝕟𝕥𝕖 𝕡𝕒𝕝𝕒𝕓𝕣𝕒 𝕖𝕟 𝕦𝕟𝕒 𝕔𝕒𝕕𝕖𝕟𝕒 𝕕𝕖 𝕥𝕖𝕩𝕥𝕠. 𝔸𝕤𝕚́ 𝕗𝕦𝕟𝕔𝕚𝕠𝕟𝕒𝕟 𝕥𝕠𝕕𝕠𝕤 𝕝𝕠𝕤 𝕘𝕣𝕒𝕟𝕕𝕖𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕕𝕖 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖.

ℙ𝕖𝕣𝕠 𝕖𝕤𝕒 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒 𝕟𝕠 𝕖𝕤 𝕤𝕦𝕗𝕚𝕔𝕚𝕖𝕟𝕥𝕖. 𝕃𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕢𝕦𝕖 𝕘𝕖𝕟𝕖𝕣𝕒𝕟 𝕝𝕠𝕤 𝕃𝕃𝕄𝕤 𝕟𝕠 𝕤𝕚𝕖𝕞𝕡𝕣𝕖 𝕤𝕠𝕟 𝕒𝕕𝕒𝕡𝕥𝕒𝕓𝕝𝕖𝕤 𝕒 𝕝𝕠𝕤 𝕙𝕦𝕞𝕒𝕟𝕠𝕤, 𝕖𝕟𝕥𝕠𝕟𝕔𝕖𝕤 𝕦𝕟𝕠 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕒 𝕦𝕟 𝕒𝕝𝕘𝕠𝕣𝕚𝕥𝕞𝕠 𝕕𝕖 𝕣𝕖𝕔𝕠𝕞𝕡𝕖𝕟𝕤𝕒, 𝕦𝕟𝕒 𝕗𝕦𝕟𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕣𝕖𝕔𝕠𝕞𝕡𝕖𝕟𝕤𝕒 𝕕𝕠𝕟𝕕𝕖 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕤𝕖 𝕤𝕚𝕖𝕟𝕥𝕒 𝕣𝕖𝕔𝕠𝕞𝕡𝕖𝕟𝕤𝕒𝕕𝕠 𝕡𝕠𝕣 𝕘𝕖𝕟𝕖𝕣𝕒𝕣 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕝𝕖𝕘𝕚𝕓𝕝𝕖𝕤 𝕡𝕒𝕣𝕒 𝕙𝕦𝕞𝕒𝕟𝕠𝕤 𝕢𝕦𝕖 𝕤𝕖 𝕤𝕚𝕖𝕟𝕥𝕒𝕟 𝕔𝕠𝕞𝕠 𝕦𝕟𝕒 𝕔𝕠𝕟𝕧𝕖𝕣𝕤𝕒𝕔𝕚𝕠́𝕟. 𝔼𝕤𝕒 𝕖𝕤 𝕝𝕒 𝕚𝕟𝕟𝕠𝕧𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕀, 𝕕𝕠𝕟𝕕𝕖 𝕔𝕠𝕟𝕥𝕣𝕒𝕥𝕒𝕟𝕕𝕠 𝕒 𝕞𝕚𝕝𝕖𝕤 𝕪 𝕞𝕚𝕝𝕖𝕤 𝕪 𝕞𝕚𝕝𝕖𝕤 𝕕𝕖 𝕡𝕖𝕣𝕤𝕠𝕟𝕒𝕤, 𝕒𝕡𝕒𝕣𝕖𝕟𝕥𝕖𝕞𝕖𝕟𝕥𝕖 𝕖𝕟 𝕂𝕖𝕟𝕚𝕒, 𝕡𝕦𝕤𝕚𝕖𝕣𝕠𝕟 𝕒 𝕙𝕒𝕓𝕝𝕒𝕣 𝕒 𝕖𝕤𝕒𝕤 𝕡𝕖𝕣𝕤𝕠𝕟𝕒𝕤. ℙ𝕖𝕣𝕤𝕠𝕟𝕒𝕤 𝕔𝕠𝕟 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕪 𝕕𝕖𝕔𝕚𝕣𝕝𝕖 𝕞𝕦𝕪 𝕓𝕚𝕖𝕟 𝕠 𝕞𝕦𝕪 𝕞𝕒𝕝. ℂ𝕒𝕕𝕒 𝕧𝕖𝕫 𝕢𝕦𝕖 𝕣𝕖𝕤𝕡𝕠𝕟𝕕𝕚́𝕒 𝕔𝕠𝕞𝕠 𝕤𝕚 𝕗𝕦𝕖𝕣𝕒 𝕦𝕟 𝕔𝕙𝕒𝕥 𝕖𝕤𝕥𝕖 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕤𝕖 𝕝𝕝𝕒𝕞𝕒 𝕣𝕝𝕗 𝕠 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘 𝕨𝕚𝕥𝕙 𝕙𝕦𝕞𝕒𝕟 𝕗𝕖𝕖𝕕𝕓𝕒𝕔𝕜. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕠 𝕥𝕖𝕣𝕞𝕚𝕟𝕒 𝕕𝕖 𝕥𝕦𝕟𝕖𝕒𝕣 𝕔𝕠𝕞𝕠 𝕕𝕖 𝕣𝕖𝕗𝕚𝕟𝕒𝕣 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠, 𝕝𝕠 𝕔𝕠𝕟𝕠𝕔𝕖𝕞𝕠𝕤 𝕔𝕠𝕞𝕠 𝕤𝕦𝕡𝕖𝕣𝕧𝕚𝕤 𝕗𝕚𝕟𝕖 𝕥𝕦𝕟𝕚𝕟𝕘 𝕪 𝕔𝕒𝕤𝕚 𝕥𝕠𝕕𝕠𝕤 𝕝𝕠𝕤 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕥𝕚𝕖𝕟𝕖𝕟 𝕖𝕤𝕥𝕠. 𝔻𝕖𝕤𝕡𝕦𝕖́𝕤 𝕕𝕖𝕝 𝕤𝕦𝕡𝕖𝕣𝕧𝕚𝕤 𝕗𝕚𝕟𝕖 𝕥𝕦𝕟𝕚𝕟𝕘 𝕧𝕚𝕖𝕟𝕖 𝕦𝕟 𝕤𝕖𝕘𝕦𝕟𝕕𝕠 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕢𝕦𝕖 𝕤𝕖 𝕝𝕝𝕒𝕞𝕒 𝕡𝕣𝕖𝕗𝕖𝕣𝕖𝕟𝕔𝕖 𝕥𝕦𝕟𝕚𝕟𝕘 𝕠 𝕣𝕖𝕗𝕚𝕟𝕒𝕕𝕠 𝕕𝕖 𝕡𝕣𝕖𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒 𝕢𝕦𝕖 𝕖𝕤 𝕝𝕠 𝕢𝕦𝕖 𝕙𝕒𝕔𝕖 𝕢𝕦𝕖 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕥𝕖𝕟𝕘𝕒 𝕔𝕚𝕖𝕣𝕥𝕒𝕤 𝕣𝕖𝕤𝕥𝕣𝕚𝕔𝕔𝕚𝕠𝕟𝕖𝕤, 𝕢𝕦𝕖 𝕥𝕖 𝕕𝕚𝕘𝕒 𝕔𝕠𝕞𝕠 𝕞𝕠𝕕𝕖𝕝𝕠 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖 𝕪𝕠 𝕟𝕠 𝕡𝕦𝕖𝕕𝕠 𝕙𝕒𝕔𝕖𝕣 𝕖𝕤𝕠 𝕪 𝕢𝕦𝕖 𝕥𝕖 𝕙𝕒𝕓𝕝𝕖 𝕔𝕠𝕞𝕠 𝕔𝕠𝕟 𝕝𝕠𝕤 𝕒𝕝𝕚𝕟𝕖𝕒𝕞𝕚𝕖𝕟𝕥𝕠𝕤 𝕡𝕒𝕣𝕒 𝕢𝕦𝕖 𝕖𝕤𝕥𝕖́ 𝕒𝕝𝕚𝕟𝕖𝕒𝕕𝕠 𝕒 𝕝𝕒 𝕣𝕒𝕫𝕒 𝕙𝕦𝕞𝕒𝕟𝕒. ℝ𝟙 𝕟𝕠 𝕦𝕤𝕒 𝕙𝕦𝕞𝕒𝕟𝕠𝕤, 𝕟𝕠 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕒 𝕣𝕖𝕗𝕠𝕣𝕞 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘 𝕨𝕚𝕥𝕙 𝕙𝕦𝕞𝕒𝕟 𝕗𝕖𝕖𝕕𝕓𝕒𝕔𝕜.

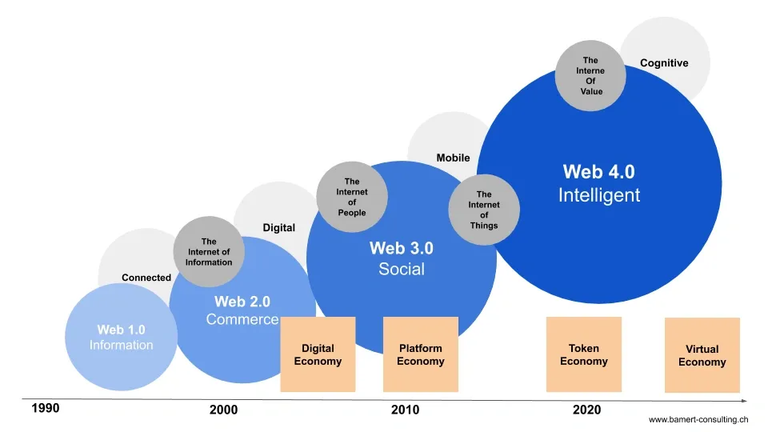

Hive y la Web 4.0: ampliando el estándar de forma inteligente

𝔼𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘 𝕝𝕠 𝕙𝕚𝕫𝕠 𝕔𝕠𝕟 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕒𝕟𝕥𝕖𝕣𝕚𝕠𝕣 𝕢𝕦𝕖 𝕔𝕣𝕖𝕒𝕣𝕠𝕟 𝕝𝕝𝕒𝕞𝕒𝕕𝕠 ℝ𝟙𝟘 𝕢𝕦𝕖 𝕖𝕤 𝕝𝕒 𝕝𝕠𝕔𝕦𝕣𝕒 𝕡𝕒𝕣𝕒 𝕟𝕠 𝕙𝕒𝕔𝕖𝕣𝕝𝕠 𝕞𝕦𝕪 𝕔𝕠𝕞𝕡𝕝𝕖𝕛𝕠 𝕔𝕠𝕟 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕚𝕟𝕚𝕔𝕚𝕒𝕝 𝕕𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠. ℂ𝕠𝕟𝕤𝕥𝕣𝕦𝕪𝕖𝕣𝕠𝕟 𝟞𝟘𝟘,𝟘𝟘𝟘 𝕖𝕛𝕖𝕞𝕡𝕝𝕠𝕤 𝕕𝕖 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕟 𝕖𝕝 𝕢𝕦𝕖 𝕦𝕟𝕒 𝕡𝕣𝕖𝕘𝕦𝕟𝕥𝕒 𝕥𝕚𝕖𝕟𝕖 𝕦𝕟𝕒 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒 𝕣𝕒𝕫𝕠𝕟𝕒𝕕𝕒 𝕪 𝕖𝕤𝕠𝕤 𝟞𝟘𝟘𝟘 𝕖𝕛𝕖𝕞𝕡𝕝𝕠𝕤 𝕕𝕖 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕝𝕠𝕤 𝕡𝕒𝕤𝕒𝕣𝕠𝕟 𝕒 𝕝𝕒 𝕗𝕦𝕖𝕣𝕫𝕒 𝕒𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕗𝕚𝕟𝕒𝕝 𝕢𝕦𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕣𝕠𝕟. ℙ𝕖𝕣𝕠, ¿𝕔𝕠́𝕞𝕠 𝕝𝕖 𝕙𝕚𝕔𝕚𝕖𝕣𝕠𝕟 𝕤𝕚𝕟 𝕙𝕦𝕞𝕒𝕟𝕠𝕤 𝕡𝕒𝕣𝕒 𝕕𝕖𝕥𝕖𝕔𝕥𝕒𝕣 𝕤𝕚 𝕦𝕟𝕒 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒 𝕒 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕣𝕒 𝕝𝕒 𝕔𝕠𝕣𝕣𝕖𝕔𝕥𝕒 𝕠 𝕝𝕒 𝕚𝕟𝕔𝕠𝕣𝕣𝕖𝕔𝕥𝕒? ℙ𝕦𝕖𝕤, 𝕝𝕖 𝕡𝕣𝕖𝕘𝕦𝕟𝕥𝕒𝕣𝕠𝕟 𝕔𝕠𝕤𝕒𝕤 𝕢𝕦𝕖 𝕝𝕒 𝕔𝕠𝕞𝕡𝕦𝕥𝕒𝕔𝕚𝕠́𝕟 𝕟𝕠𝕣𝕞𝕒𝕝 𝕡𝕠𝕕𝕚́𝕒 𝕧𝕖𝕣𝕚𝕗𝕚𝕔𝕒𝕣. ℙ𝕠𝕣 𝕖𝕛𝕖𝕞𝕡𝕝𝕠, 𝕤𝕚 𝕪𝕠 𝕝𝕖 𝕡𝕚𝕕𝕠 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕢𝕦𝕖 𝕞𝕖 𝕘𝕖𝕟𝕖𝕣𝕖 𝟝𝟘𝟘 𝕕𝕚𝕗𝕖𝕣𝕖𝕟𝕥𝕖𝕤 𝕖𝕔𝕦𝕒𝕔𝕚𝕠𝕟𝕖𝕤 𝕞𝕒𝕥𝕖𝕞𝕒́𝕥𝕚𝕔𝕒𝕤 𝕢𝕦𝕖 𝕞𝕖 𝕝𝕝𝕖𝕧𝕖𝕟 𝕒𝕝 𝕟𝕦́𝕞𝕖𝕣𝕠 𝟜𝟚, 𝕡𝕦𝕖𝕤 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕧𝕒 𝕒 𝕘𝕖𝕟𝕖𝕣𝕒𝕣 𝕦𝕟 𝕞𝕠𝕟𝕥𝕠́𝕟 𝕕𝕖 𝕠𝕡𝕔𝕚𝕠𝕟𝕖𝕤 𝕪 𝕡𝕦𝕖𝕕𝕖 𝕢𝕦𝕖 𝕘𝕖𝕟𝕖𝕣𝕖 𝟚𝟘𝟘𝟘. 𝔼𝕟𝕥𝕠𝕟𝕔𝕖𝕤, 𝕝𝕒𝕤 𝟙𝟘𝟘 𝕢𝕦𝕖 𝕟𝕠 𝕘𝕖𝕟𝕖𝕣𝕒𝕣𝕠𝕟 𝕖𝕝 𝕟𝕦́𝕞𝕖𝕣𝕠 𝟜𝟚 𝕝𝕚𝕥𝕖𝕣𝕒𝕝𝕞𝕖𝕟𝕥𝕖 𝕝𝕠 𝕣𝕖𝕘𝕒𝕟̃𝕠́ 𝕔𝕠𝕟 𝕖𝕝 𝕤𝕚𝕤𝕥𝕖𝕞𝕒 𝕕𝕖 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘. 𝔼𝕤𝕥𝕠 𝕟𝕠 𝕖𝕤 𝕪 𝕝𝕒𝕤 𝟝𝟘𝟘 𝕢𝕦𝕖 𝕤𝕚́ 𝕝𝕝𝕖𝕘𝕒𝕣𝕠𝕟 𝕒𝕝 𝕟𝕦́𝕞𝕖𝕣𝕠 𝟜𝟚, 𝕡𝕦𝕖𝕤 𝕪𝕠 𝕝𝕒𝕤 𝕡𝕦𝕖𝕕𝕠 𝕧𝕖𝕣𝕚𝕗𝕚𝕔𝕒𝕣 𝕔𝕠𝕟 𝕔𝕦𝕒𝕝𝕢𝕦𝕚𝕖𝕣 𝕔𝕠́𝕕𝕚𝕘𝕠 𝕕𝕖 𝕡𝕣𝕠𝕘𝕣𝕒𝕞𝕒𝕔𝕚𝕠́𝕟 𝕪 𝕝𝕖 𝕕𝕚𝕘𝕠 𝕖𝕤𝕥𝕠 𝕖𝕤 𝕦𝕟 𝕓𝕦𝕖𝕟 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕪 𝕖𝕟𝕥𝕠𝕟𝕔𝕖𝕤 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕟𝕠 𝕤𝕠𝕝𝕒𝕞𝕖𝕟𝕥𝕖 𝕣𝕖𝕔𝕚𝕓𝕖 𝕝𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤, 𝕤𝕚𝕟𝕠 𝕢𝕦𝕖 𝕖𝕟𝕥𝕖𝕟𝕕𝕚𝕠́ 𝕢𝕦𝕖 𝕖𝕤𝕖 𝕖𝕤 𝕖𝕝 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕔𝕠𝕣𝕣𝕖𝕔𝕥𝕠.

𝕆𝕥𝕣𝕠 𝕖𝕛𝕖𝕞𝕡𝕝𝕠 𝕤𝕖𝕣𝕚́𝕒 𝕡𝕖𝕕𝕚𝕣𝕝𝕖 𝕔𝕠́𝕕𝕚𝕘𝕠 𝕢𝕦𝕖 𝕘𝕖𝕟𝕖𝕣𝕖 𝕦𝕟 𝕔𝕚𝕖𝕣𝕥𝕠 𝕥𝕚𝕡𝕠 𝕕𝕖 𝕖𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕒 𝕩𝕞𝕝 𝕪 𝕝𝕦𝕖𝕘𝕠 𝕔𝕠𝕟 𝕖𝕩𝕡𝕣𝕖𝕤𝕚𝕠𝕟𝕖𝕤 𝕣𝕖𝕘𝕦𝕝𝕒𝕣𝕖𝕤 𝕕𝕖 𝕥𝕠𝕕𝕒 𝕝𝕒 𝕧𝕚𝕕𝕒. 𝕍𝕖𝕣𝕚𝕗𝕚𝕔𝕠́ 𝕤𝕚 𝕝𝕒 𝕖𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕒 𝕣𝕖𝕤𝕦𝕝𝕥𝕒𝕟𝕥𝕖 𝕖𝕤 𝕝𝕒 𝕖𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕒 𝕔𝕠𝕣𝕣𝕖𝕔𝕥𝕒 𝕪 𝕒𝕘𝕒𝕣𝕣𝕠 𝕖𝕝 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕢𝕦𝕖 𝕘𝕖𝕟𝕖𝕣𝕠́ 𝕖𝕤𝕒 𝕖𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕒 𝕪 𝕝𝕠 𝕧𝕠𝕝𝕧𝕚𝕠́ 𝕦𝕟 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥. 𝔻𝕖𝕤𝕡𝕦𝕖́𝕤 𝕕𝕖 𝕖𝕤𝕖 𝕡𝕣𝕠𝕔𝕖𝕤𝕠, 𝕝𝕠 𝕙𝕚𝕫𝕠 𝕞𝕚𝕝𝕝𝕠𝕟𝕖𝕤 𝕕𝕖 𝕧𝕖𝕔𝕖𝕤. 𝔸𝕘𝕒𝕣𝕣𝕠 𝕤𝕠𝕝𝕠 𝕝𝕒𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕧𝕒́𝕝𝕚𝕕𝕒𝕤 𝕪 𝕝𝕠 𝕡𝕒𝕤𝕠 𝕡𝕠𝕣 𝕖𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘 𝕪 𝕪𝕒 𝕖𝕤𝕥𝕒́. 𝔸𝕢𝕦𝕚́ 𝕞𝕦𝕪 𝕡𝕣𝕠𝕓𝕒𝕓𝕝𝕖𝕞𝕖𝕟𝕥𝕖 𝕝𝕠𝕤 𝕔𝕙𝕚𝕟𝕠𝕤 𝕥𝕒𝕞𝕓𝕚𝕖́𝕟 𝕤𝕖 𝕒𝕡𝕣𝕠𝕧𝕖𝕔𝕙𝕒𝕣𝕠𝕟 𝕕𝕖 𝕕𝕒𝕥𝕠𝕤 𝕤𝕚𝕟𝕥𝕖́𝕥𝕚𝕔𝕠𝕤 𝕔𝕣𝕖𝕒𝕕𝕠𝕤 𝕔𝕠𝕟 ℂ𝕙𝕒𝕥𝔾ℙ𝕋 𝟜 (𝕤𝕚𝕖𝕞𝕡𝕣𝕖 𝕔𝕠𝕡𝕚𝕒𝕟𝕕𝕠), 𝕦𝕤𝕒𝕟𝕕𝕠 𝕝𝕒 𝔸ℙ𝕀 𝕠 𝕦𝕤𝕒𝕟𝕕𝕠 𝕚𝕟𝕔𝕝𝕦𝕤𝕠 𝕖𝕝 𝕞𝕖𝕔𝕒𝕟𝕚𝕤𝕞𝕠 𝕕𝕖 𝕔𝕙𝕒𝕥, 𝕪 𝕡𝕦𝕖𝕕𝕖 𝕢𝕦𝕖 𝕙𝕒𝕪𝕒𝕟 𝕦𝕤𝕒𝕕𝕠 𝕃𝕝𝕒𝕞𝕒 𝕤𝕚𝕟 𝕝𝕒 𝕞𝕖𝕟𝕠𝕣 𝕕𝕦𝕕𝕒; 𝕦𝕤𝕒𝕣𝕠𝕟 𝕃𝕝𝕒𝕞𝕒 𝕔𝕒𝕤𝕚 𝕤𝕖𝕘𝕦𝕣𝕠 𝕢𝕦𝕖 𝕦𝕤𝕒𝕣𝕠𝕟 𝕔𝕝𝕠𝕥𝕙. ℕ𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒, 𝕝𝕠 𝕢𝕦𝕖 𝕚𝕞𝕡𝕠𝕣𝕥𝕒 𝕖𝕤 𝕢𝕦𝕖 𝕪𝕒 𝕟𝕠 𝕤𝕖 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕒𝕟 𝕙𝕦𝕞𝕒𝕟𝕠𝕤 𝕡𝕒𝕣𝕒 𝕝𝕒 𝕣𝕖𝕥𝕣𝕠𝕒𝕝𝕚𝕞𝕖𝕟𝕥𝕒𝕔𝕚𝕠́𝕟 𝕪 𝕖𝕝 𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕓𝕒𝕤𝕖 𝕪𝕒 𝕟𝕠 𝕖𝕤 𝕝𝕠 𝕚𝕞𝕡𝕠𝕣𝕥𝕒𝕟𝕥𝕖. 𝔼𝕝 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘 𝕤𝕖 𝕒𝕔𝕒𝕓𝕠́ 𝕔𝕠𝕞𝕠 𝕦𝕟𝕠 𝕕𝕖 𝕝𝕠𝕤 𝕞𝕖𝕔𝕒𝕟𝕚𝕤𝕞𝕠𝕤 𝕕𝕖 𝕔𝕠𝕞𝕡𝕖𝕥𝕖𝕟𝕔𝕚𝕒.

𝕃𝕒 𝕠𝕥𝕣𝕒 𝕘𝕣𝕒𝕟 𝕚𝕟𝕟𝕠𝕧𝕒𝕔𝕚𝕠́𝕟 𝕖𝕤 𝕝𝕠 𝕞𝕚𝕤𝕞𝕠 𝕢𝕦𝕖 𝕙𝕒𝕔𝕖 𝕦𝕟𝕠 𝕡𝕖𝕟𝕤𝕒𝕣 𝕔𝕦𝕒𝕟𝕕𝕠 𝕦𝕤𝕥𝕖𝕕𝕖𝕤 𝕦𝕤𝕒𝕟 𝕕𝕖𝕖𝕡𝕤 ℝ𝟙. ℙ𝕣𝕚𝕞𝕖𝕣𝕠 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕖𝕞𝕡𝕚𝕖𝕫𝕒 𝕒 “𝕡𝕖𝕟𝕤𝕒𝕣” 𝕪 𝕝𝕖𝕤 𝕞𝕦𝕖𝕤𝕥𝕣𝕒 𝕖𝕝 𝕡𝕖𝕟𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕟 𝕡𝕦́𝕓𝕝𝕚𝕔𝕠 𝕠 𝕦𝕟𝕠 𝕞𝕦𝕖𝕤𝕥𝕣𝕒 𝕦𝕟𝕒 𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕣𝕖𝕤𝕦𝕞𝕚𝕕𝕒 𝕕𝕖𝕝 𝕡𝕖𝕟𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠. 𝔻𝕖𝕖𝕡𝕤 ℝ𝟙 𝕝𝕖𝕤 𝕞𝕦𝕖𝕤𝕥𝕣𝕒 𝕥𝕠𝕕𝕠 𝕤𝕦 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕡𝕖𝕟𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕔𝕠𝕞𝕡𝕝𝕖𝕥𝕒𝕞𝕖𝕟𝕥𝕖 𝕒𝕓𝕚𝕖𝕣𝕥𝕠. 𝔻𝕖 𝕙𝕖𝕔𝕙𝕠, 𝕖𝕤 𝕥𝕒𝕟 𝕓𝕠𝕟𝕚𝕥𝕠 𝕢𝕦𝕖 𝕞𝕦𝕔𝕙𝕒 𝕘𝕖𝕟𝕥𝕖 𝕖𝕤𝕥𝕒́ 𝕕𝕚𝕔𝕚𝕖𝕟𝕕𝕠, 𝕞𝕖 𝕖𝕟𝕔𝕒𝕟𝕥𝕒 𝕢𝕦𝕖 𝕝𝕒 𝕀𝕀 𝕞𝕖 𝕕𝕚𝕘𝕒 𝕔𝕠́𝕞𝕠 𝕖𝕤𝕥𝕒́ 𝕡𝕖𝕟𝕤𝕒𝕟𝕕𝕠 𝕪 𝕝𝕠 𝕡𝕦𝕖𝕕𝕠 𝕖𝕤𝕔𝕠𝕟𝕕𝕖𝕣 𝕠 𝕕𝕖𝕤𝕡𝕝𝕖𝕘𝕒𝕣. 𝕐𝕠 𝕔𝕣𝕖𝕠 𝕢𝕦𝕖 𝕖𝕝𝕝𝕠𝕤 𝕔𝕣𝕖𝕒𝕣𝕠𝕟 𝕦𝕟 𝕟𝕦𝕖𝕧𝕠 𝕡𝕒𝕣𝕒𝕕𝕚𝕘𝕞𝕒 𝕕𝕖 𝕚𝕟𝕥𝕖𝕣𝕗𝕒𝕫 𝕘𝕣𝕒́𝕗𝕚𝕔𝕒 𝕕𝕖𝕓𝕚𝕕𝕠 𝕒 𝕖𝕤𝕥𝕠 𝕪 𝕖𝕤𝕥𝕠 𝕘𝕖𝕟𝕖𝕣𝕒 𝕕𝕠𝕤 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒𝕤 𝕖𝕟 𝕦𝕟 𝕗𝕠𝕣𝕞𝕒𝕥𝕠 𝕩𝕞𝕝. 𝔼𝕟 𝕖𝕥𝕚𝕢𝕦𝕖𝕥𝕒𝕤 𝕥𝕙𝕚𝕟𝕜 𝕖𝕤𝕥𝕒́ 𝕖𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕠 𝕕𝕖 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕪 𝕖𝕟 𝕖𝕥𝕚𝕢𝕦𝕖𝕥𝕒𝕤 𝕒𝕟𝕤𝕨𝕖𝕣 𝕖𝕤𝕥𝕒́ 𝕝𝕒 𝕣𝕖𝕤𝕡𝕦𝕖𝕤𝕥𝕒 𝕗𝕚𝕟𝕒𝕝 𝕪 𝕖𝕤𝕠 𝕘𝕖𝕟𝕖𝕣𝕒 𝕦𝕟 𝕣𝕒𝕫𝕠𝕟𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕢𝕦𝕚𝕧𝕒𝕝𝕖𝕟𝕥𝕖 𝕒𝕝 𝕕𝕖 𝕦𝕟𝕠 𝟝𝟘 𝕧𝕖𝕔𝕖𝕤 𝕞𝕒́𝕤 𝕓𝕒𝕣𝕒𝕥𝕠. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕥𝕠 𝕤𝕠𝕟 𝕞𝕖𝕛𝕠𝕣𝕒𝕤 𝕓𝕒𝕤𝕒𝕕𝕒𝕤 𝕖𝕟 𝕚𝕟𝕘𝕖𝕟𝕚𝕖𝕣𝕚́𝕒 𝕕𝕖 𝕤𝕠𝕗𝕥𝕨𝕒𝕣𝕖 𝕪 𝕔𝕚𝕖𝕟𝕔𝕚𝕒𝕤 𝕕𝕖 𝕔𝕠𝕞𝕡𝕦𝕥𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕥𝕠𝕕𝕒 𝕝𝕒 𝕧𝕚𝕕𝕒. 𝔼𝕤𝕥𝕠𝕤 𝕟𝕠 𝕤𝕠𝕟 𝕘𝕖𝕟𝕚𝕠𝕤 𝕞𝕒𝕥𝕖𝕞𝕒́𝕥𝕚𝕔𝕠𝕤 𝕕𝕖𝕝 𝕗𝕦𝕥𝕦𝕣𝕠 𝕟𝕚 𝕗𝕦𝕟𝕕𝕒𝕕𝕠𝕣𝕖𝕤 𝕥𝕚𝕥𝕒́𝕟𝕚𝕔𝕠𝕤 𝕢𝕦𝕖 𝕤𝕠𝕟 𝕔𝕒𝕡𝕒𝕔𝕖𝕤 𝕕𝕖 𝕝𝕖𝕧𝕒𝕟𝕥𝕒𝕣 𝕓𝕚𝕝𝕝𝕠𝕟𝕖𝕤 𝕕𝕖 𝕕𝕠́𝕝𝕒𝕣𝕖𝕤 𝕕𝕖 𝕗𝕠𝕟𝕕𝕠𝕤 𝕤𝕠𝕓𝕖𝕣𝕒𝕟𝕠𝕤 𝕪 𝕒𝕙𝕠𝕣𝕒 𝕖𝕝 𝕞𝕦𝕟𝕕𝕠 𝕝𝕠 𝕤𝕒𝕓𝕖.

𝕐 𝕤𝕚́, 𝕔𝕠𝕞𝕠 𝕖𝕤 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕔𝕙𝕚𝕟𝕠 𝕥𝕚𝕖𝕟𝕖 𝕔𝕖𝕟𝕤𝕦𝕣𝕒 𝕒𝕡𝕝𝕚𝕔𝕒𝕕𝕒 𝕖𝕟 𝕤𝕦 𝕣𝕖𝕚𝕟𝕗𝕠𝕣𝕔𝕖𝕞𝕖𝕟𝕥 𝕝𝕖𝕒𝕣𝕟𝕚𝕟𝕘, 𝕡𝕖𝕣𝕠 𝕖𝕟 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕢𝕦𝕖 𝕪𝕠 𝕖𝕤𝕥𝕦𝕧𝕖 𝕡𝕣𝕠𝕓𝕒𝕟𝕕𝕠 𝕖𝕟 𝕝𝕠𝕔𝕒𝕝 𝕪 𝕢𝕦𝕖 𝕖𝕤𝕥𝕦𝕧𝕖 𝕡𝕣𝕠𝕓𝕒𝕟𝕕𝕠 𝕖𝕟 𝕝𝕠𝕤 𝕤𝕖𝕣𝕧𝕚𝕕𝕠𝕣𝕖𝕤 𝕕𝕖 𝕦𝕟𝕠𝕤 𝕒𝕞𝕚𝕘𝕠𝕤 𝕟𝕠 𝕙𝕒𝕪 𝕔𝕖𝕟𝕤𝕦𝕣𝕒. 𝕃𝕒 𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕢𝕦𝕖 𝕦𝕟𝕠 𝕤𝕖 𝕡𝕦𝕖𝕕𝕖 𝕚𝕟𝕤𝕥𝕒𝕝𝕒𝕣 𝕖𝕤𝕥𝕒́ 𝕔𝕠𝕞𝕡𝕝𝕖𝕥𝕒𝕞𝕖𝕟𝕥𝕖 𝕒𝕓𝕚𝕖𝕣𝕥𝕒. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕥𝕠 𝕪𝕠 𝕝𝕠 𝕔𝕠𝕟𝕥𝕣𝕒𝕤𝕥𝕠 𝕔𝕠𝕟 𝕢𝕦𝕖 𝕊𝕒𝕞 𝔸𝕝𝕥𝕞𝕒𝕟 𝕒𝕟𝕦𝕟𝕔𝕚𝕠́ 𝕣𝕖𝕔𝕚𝕖𝕟𝕥𝕖𝕞𝕖𝕟𝕥𝕖 𝕛𝕦𝕟𝕥𝕠 𝕔𝕠𝕟 𝕖𝕙 𝕃𝕒𝕣𝕣𝕪 𝔼𝕝𝕝𝕚𝕤𝕠𝕟, 𝕖𝕝 𝕗𝕦𝕟𝕕𝕒𝕕𝕠𝕣 𝕕𝕖 𝕆𝕣𝕒𝕔𝕝𝕖 𝕪 𝕔𝕠𝕟 𝕄𝕒𝕤𝕒𝕪𝕠𝕤𝕙𝕚 𝕊𝕠𝕟, 𝕖𝕝 𝕗𝕦𝕟𝕕𝕒𝕕𝕠𝕣 𝕕𝕖 𝕊𝕠𝕗𝕥𝕓𝕒𝕟𝕜, 𝕒𝕝 𝕝𝕒𝕕𝕠 𝕕𝕖 𝕋𝕣𝕦𝕞𝕡 𝕝𝕒 𝕚𝕟𝕧𝕖𝕣𝕤𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕖𝕕𝕚𝕠 𝕥𝕣𝕚𝕝𝕝𝕠́𝕟 𝕕𝕖 𝕕𝕠́𝕝𝕒𝕣𝕖𝕤, 𝟝𝟘𝟘 𝕓𝕚𝕝𝕝𝕠𝕟 𝕖𝕟 𝕟𝕦́𝕞𝕖𝕣𝕠𝕤 𝕘𝕣𝕚𝕟𝕘𝕠𝕤, 𝕢𝕦𝕖 𝕖𝕤 𝕦𝕟 𝕟𝕦́𝕞𝕖𝕣𝕠 𝕖𝕤 𝕦𝕟 𝕟𝕦́𝕞𝕖𝕣𝕠 𝕚𝕟𝕚𝕞𝕒𝕘𝕚𝕟𝕒𝕓𝕝𝕖 𝕡𝕒𝕣𝕒 𝕚𝕟𝕧𝕖𝕣𝕥𝕚𝕣 𝕖𝕟 𝕤𝕖𝕣𝕧𝕚𝕕𝕠𝕣𝕖𝕤. ℙ𝕚𝕖𝕟𝕤𝕖𝕟 𝕢𝕦𝕖 𝕄𝕚𝕔𝕣𝕠𝕤𝕠𝕗𝕥 𝕥𝕚𝕖𝕟𝕖 𝕞𝕖𝕕𝕚𝕠 𝕞𝕚𝕝𝕝𝕠́𝕟 𝕕𝕖 𝕔𝕙𝕚𝕡𝕤 𝕕𝕖 𝕖𝕤𝕥𝕠𝕤, 𝕢𝕦𝕖 𝕄𝕖𝕥𝕒 𝕖𝕤 𝕖𝕝 𝕠𝕥𝕣𝕠 𝕘𝕣𝕒𝕟𝕕𝕠𝕥𝕖, 𝕔𝕣𝕖𝕠 𝕢𝕦𝕖 𝕥𝕚𝕖𝕟𝕖𝕟 𝕔𝕠𝕞𝕠 𝟚𝟘𝟘,𝟘𝟘𝟘 𝕔𝕙𝕚𝕡𝕤 𝕕𝕖 𝕝𝕠𝕤 𝕔𝕙𝕚𝕡𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕠𝕤 𝕪 𝕖𝕤𝕥𝕒 𝕘𝕖𝕟𝕥𝕖 𝕝𝕠 𝕝𝕠𝕘𝕣𝕠́ 𝕔𝕠𝕟 𝕔𝕙𝕚𝕡𝕤 𝕓𝕒𝕣𝕒𝕥𝕠𝕤. 𝕋𝕠𝕕𝕠 𝕖𝕤𝕥𝕠 𝕦𝕤𝕒𝕟𝕕𝕠 𝕝𝕒 𝕡𝕣𝕖𝕞𝕚𝕤𝕒 𝕕𝕖 𝕢𝕦𝕖 𝕝𝕒 𝕚𝕟𝕥𝕖𝕝𝕚𝕘𝕖𝕟𝕔𝕚𝕒 𝕒𝕣𝕥𝕚𝕗𝕚𝕔𝕚𝕒𝕝 𝕤𝕠𝕝𝕒𝕞𝕖𝕟𝕥𝕖 𝕥𝕚𝕖𝕟𝕖 𝕦𝕟𝕒 𝕗𝕠𝕣𝕞𝕒 𝕕𝕖 𝕔𝕣𝕖𝕔𝕖𝕣 𝕪 𝕖𝕤 𝕥𝕚𝕣𝕒𝕣𝕝𝕖 𝕔𝕙𝕚𝕡𝕤 𝕒𝕝 𝕡𝕣𝕠𝕓𝕝𝕖𝕞𝕒, 𝕡𝕝𝕒𝕥𝕒 𝕪 𝕔𝕙𝕚𝕡𝕤, 𝕡𝕝𝕒𝕥𝕒 𝕪 𝕔𝕙𝕚𝕡𝕤, 𝕕𝕒𝕥𝕒𝕔𝕖𝕟𝕥𝕖𝕣𝕤 𝕙𝕒𝕤𝕥𝕒 𝕕𝕠𝕟𝕕𝕖 𝕖𝕝 𝕕𝕖𝕤𝕚𝕖𝕣𝕥𝕠 𝕕𝕖 𝔸𝕣𝕚𝕫𝕠𝕟𝕒.

𝕃𝕠 𝕢𝕦𝕖 𝕖𝕤 𝕦𝕟 𝕔𝕙𝕚𝕡 𝕖𝕤 𝕓𝕒́𝕤𝕚𝕔𝕒𝕞𝕖𝕟𝕥𝕖 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕪 𝕡𝕣𝕠𝕔𝕖𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠, 𝕝𝕒 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕖𝕤 𝕖𝕝 𝕥𝕒𝕞𝕒𝕟̃𝕠 𝕕𝕖 𝕝𝕒 𝕧𝕖𝕟𝕥𝕒𝕟𝕒 𝕕𝕖 𝕔𝕠𝕟𝕥𝕖𝕩𝕥𝕠 𝕪 𝕖𝕝 𝕡𝕣𝕠𝕔𝕖𝕤𝕒𝕞𝕚𝕖𝕟𝕥𝕠 𝕖𝕤 𝕝𝕒 𝕧𝕖𝕝𝕠𝕔𝕚𝕕𝕒𝕕 𝕔𝕠𝕟 𝕝𝕒 𝕢𝕦𝕖 𝕤𝕒𝕝𝕖𝕟 𝕝𝕠𝕤 𝕥𝕠𝕜𝕖𝕟𝕤. ℝ𝟙 𝕔𝕒𝕞𝕓𝕚𝕠́ 𝕖𝕝 𝕛𝕦𝕖𝕘𝕠 𝕡𝕠𝕣𝕢𝕦𝕖 𝕔𝕠𝕟 𝕦𝕟𝕒 𝕗𝕣𝕒𝕔𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕖𝕞𝕠𝕣𝕚𝕒 𝕪 𝕞𝕦𝕔𝕙𝕠 𝕞𝕖𝕟𝕠𝕤 ℂℙ𝕌 𝕠 𝔾ℙ𝕌 𝕖𝕤𝕥𝕒́ 𝕝𝕠𝕘𝕣𝕒𝕟𝕕𝕠 𝕣𝕖𝕤𝕦𝕝𝕥𝕒𝕕𝕠𝕤 𝕤𝕚𝕞𝕚𝕝𝕒𝕣𝕖𝕤. 𝔸𝕢𝕦𝕚́ 𝕝𝕠 𝕢𝕦𝕖 𝕧𝕒 𝕒 𝕡𝕒𝕤𝕒𝕣 𝕖𝕤 𝕢𝕦𝕖 𝕥𝕠𝕕𝕒𝕤 𝕝𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕧𝕒𝕟 𝕒 𝕖𝕞𝕡𝕖𝕫𝕒𝕣 𝕒 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕒𝕣 𝕡𝕠𝕣𝕢𝕦𝕖 𝕪𝕒 𝕤𝕖𝕘𝕦𝕣𝕠 𝕖𝕞𝕡𝕖𝕫𝕒𝕣𝕠𝕟 𝕒 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕒𝕣 𝕝𝕒𝕤 𝕞𝕖𝕛𝕠𝕣𝕒𝕤 𝕕𝕖 ℝ𝟙. 𝕍𝕒𝕞𝕠𝕤 𝕒 𝕧𝕖𝕣 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕃𝕒𝕞𝕒 𝕢𝕦𝕖 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕖 𝕝𝕠 ℝ𝟙, 𝕧𝕒𝕞𝕠𝕤 𝕒 𝕧𝕖𝕣 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕆𝕡𝕖𝕟𝔸𝕚 𝕢𝕦𝕖 𝕚𝕞𝕡𝕝𝕖𝕞𝕖𝕟𝕥𝕖 𝕝𝕠 ℝ𝟙 𝕕𝕖 𝔸𝕟𝕥𝕙𝕣𝕠𝕡𝕚𝕔 𝕔𝕠𝕟 ℂ𝕝𝕠𝕥. 𝕋𝕠𝕕𝕠 𝕖𝕝 𝕞𝕦𝕟𝕕𝕠. ℙ𝕖𝕣𝕠 𝕖𝕤𝕠 𝕟𝕠 𝕖𝕤 𝕝𝕠 𝕢𝕦𝕖 𝕚𝕞𝕡𝕠𝕣𝕥𝕒, 𝕝𝕠 𝕢𝕦𝕖 𝕚𝕞𝕡𝕠𝕣𝕥𝕒 𝕖𝕤 𝕔𝕠́𝕞𝕠 𝕔𝕒𝕞𝕓𝕚𝕠́ 𝕖𝕝 𝕛𝕦𝕖𝕘𝕠, 𝕡𝕠𝕣𝕢𝕦𝕖 𝕥𝕒𝕟𝕥𝕠𝕤 𝕡𝕣𝕠𝕧𝕖𝕖𝕕𝕠𝕣𝕖𝕤 𝕕𝕖 ℂ𝕝𝕠𝕦𝕕 𝕚𝕟𝕧𝕚𝕣𝕥𝕚𝕖𝕣𝕠𝕟 𝕖𝕟 𝕖𝕤𝕥𝕠𝕤 𝕔𝕙𝕚𝕡𝕤, 𝕢𝕦𝕖 𝕟𝕠 𝕖𝕤 𝕔𝕠𝕞𝕠 𝕢𝕦𝕖 𝕧𝕒𝕟 𝕒 𝕡𝕖𝕣𝕕𝕖𝕣 𝕝𝕒 𝕡𝕝𝕒𝕥𝕒. 𝔼𝕟𝕥𝕠𝕟𝕔𝕖𝕤 𝕧𝕒𝕟 𝕒 𝕖𝕞𝕡𝕖𝕫𝕒𝕣 𝕒 𝕧𝕖𝕟𝕕𝕖𝕣 𝕞𝕒́𝕤 𝕓𝕒𝕣𝕒𝕥𝕠 𝕖𝕝 𝕥𝕚𝕖𝕞𝕡𝕠 𝕕𝕖 ℂ𝕙𝕚𝕡 𝕡𝕠𝕣𝕢𝕦𝕖 𝕒𝕙𝕠𝕣𝕒 𝕤𝕖 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕒 𝕞𝕖𝕟𝕠𝕤. 𝕃𝕒𝕤 𝕖𝕞𝕡𝕣𝕖𝕤𝕒𝕤 𝕢𝕦𝕖 𝕢𝕦𝕚𝕖𝕣𝕖𝕟 𝕦𝕤𝕒𝕣 𝔸𝕀 𝕡𝕒𝕣𝕒 𝕘𝕖𝕟𝕖𝕣𝕒𝕣 𝕤𝕠𝕝𝕦𝕔𝕚𝕠𝕟𝕖𝕤 𝕡𝕒𝕣𝕒 𝕝𝕒𝕤 𝕠𝕥𝕣𝕒𝕤 𝕔𝕠𝕞𝕡𝕒𝕟̃𝕚́𝕒𝕤, 𝕔𝕠𝕞𝕠 𝕡𝕒𝕣𝕥𝕖 𝕕𝕖 𝕤𝕦𝕤 𝕡𝕣𝕠𝕕𝕦𝕔𝕥𝕠𝕤, 𝕝𝕖𝕤 𝕧𝕒 𝕒 𝕣𝕖𝕤𝕦𝕝𝕥𝕒𝕣 𝕞𝕦𝕔𝕙𝕠 𝕞𝕒́𝕤 𝕓𝕒𝕣𝕒𝕥𝕠 𝕪 𝕝𝕠 𝕞𝕒́𝕤 𝕚𝕟𝕔𝕣𝕖𝕚́𝕓𝕝𝕖 𝕖𝕤 𝕢𝕦𝕖 𝕔𝕒𝕞𝕓𝕚𝕒 𝕝𝕒 𝕔𝕦𝕝𝕥𝕦𝕣𝕒, 𝕔𝕒𝕞𝕓𝕚𝕒 𝕝𝕒 𝕗𝕚𝕝𝕠𝕤𝕠𝕗𝕚́𝕒.

ℙ𝕒𝕣𝕒 𝕖𝕟𝕥𝕖𝕟𝕕𝕖𝕣 𝕖𝕤𝕥𝕖 𝕞𝕦𝕟𝕕𝕠, 𝕖𝕤𝕥𝕖 𝕖𝕟𝕗𝕠𝕢𝕦𝕖, ¿𝕢𝕦𝕖́ 𝕤𝕖 𝕟𝕖𝕔𝕖𝕤𝕚𝕥𝕒 𝕤𝕒𝕓𝕖𝕣?: ℚ𝕦𝕖́ 𝕖𝕤 𝕦𝕟 𝕥𝕠𝕜𝕖𝕟, 𝕢𝕦𝕖́ 𝕖𝕤 𝕦𝕟𝕒 𝕣𝕖𝕕 𝕟𝕖𝕦𝕣𝕠𝕟𝕒𝕝, 𝕢𝕦𝕖́ 𝕤𝕚𝕘𝕟𝕚𝕗𝕚𝕔𝕒 𝕔𝕠𝕣𝕣𝕚𝕞𝕚𝕖𝕟𝕥𝕠 𝕕𝕖 𝕓𝕚𝕥, 𝕔𝕦𝕒́𝕟𝕕𝕠 𝕦𝕤𝕒𝕣 𝕦𝕟 𝕒́𝕣𝕓𝕠𝕝 𝕓𝕚𝕟𝕒𝕣𝕚𝕠, 𝕔𝕠́𝕞𝕠 𝕗𝕦𝕟𝕔𝕚𝕠𝕟𝕒 𝕦𝕟 𝕥𝕣𝕒𝕟𝕤𝕗𝕠𝕣𝕞𝕒𝕕𝕠𝕣. ℚ𝕦𝕖́ 𝕖𝕤 𝕖𝕝 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕒𝕥𝕖𝕟𝕔𝕚𝕠́𝕟, 𝕢𝕦𝕖́ 𝕖𝕤 𝕦𝕟 𝕥𝕣𝕒𝕟𝕤𝕗𝕠𝕣𝕞𝕒𝕕𝕠𝕣 𝕡𝕣𝕖𝕖𝕟𝕥𝕣𝕖𝕟𝕒𝕕𝕠 𝕘𝕖𝕟𝕖𝕣𝕒𝕥𝕚𝕧𝕠 𝔾ℙ𝕋, 𝕔𝕠́𝕞𝕠 𝕤𝕖 𝕖𝕟𝕥𝕣𝕖𝕟𝕒 𝕦𝕟 𝕘𝕣𝕒𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖 𝕝𝕖𝕟𝕘𝕦𝕒𝕛𝕖, 𝕔𝕦𝕒́𝕝 𝕖𝕤 𝕝𝕒 𝕕𝕚𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒 𝕖𝕟𝕥𝕣𝕖 𝕝𝕒 ℝ𝔸𝕄 𝕪 𝕝𝕒 𝕍ℝ𝔸𝕄. ℂ𝕦𝕒́𝕝 𝕖𝕤 𝕝𝕒 𝕕𝕚𝕗𝕖𝕣𝕖𝕟𝕔𝕚𝕒 𝕖𝕟𝕥𝕣𝕖 ℂℙ𝕌, 𝔾ℙ𝕌 𝕪 𝕋ℙ𝕌, 𝕔𝕠́𝕞𝕠 𝕚𝕟𝕤𝕥𝕒𝕝𝕒𝕣 𝕃𝕝𝕒𝕞𝕒 𝕪 𝔻𝕖𝕖𝕡𝕊𝕖𝕖𝕜 𝕖𝕟 𝕝𝕠𝕔𝕒𝕝, 𝕔𝕦𝕒́𝕝 𝕖𝕤 𝕖𝕝 𝕖𝕤𝕥𝕒𝕕𝕠 𝕕𝕖𝕝 𝕒𝕣𝕥𝕖 𝕕𝕖 𝕝𝕒𝕤 𝕧𝕖𝕟𝕥𝕒𝕟𝕒𝕤 𝕕𝕖 𝕔𝕠𝕟𝕥𝕖𝕩𝕥𝕠, 𝕝𝕒𝕤 𝕥𝕖́𝕔𝕟𝕚𝕔𝕒𝕤 𝕒𝕧𝕒𝕟𝕫𝕒𝕕𝕒𝕤 𝕕𝕖 𝕡𝕣𝕠𝕞𝕡𝕥𝕚𝕟𝕘. 𝕋𝕠𝕕𝕒 𝕝𝕒 𝕘𝕖𝕟𝕥𝕖 𝕢𝕦𝕖 𝕤𝕖 𝕓𝕦𝕣𝕝𝕒𝕓𝕒 𝕕𝕖 𝕝𝕠𝕤 𝕡𝕣𝕠𝕞𝕡𝕥𝕤 𝕖𝕟𝕘𝕚𝕟𝕖𝕖𝕣𝕚𝕟𝕘 𝕖𝕤𝕥𝕒𝕓𝕒 𝕖𝕢𝕦𝕚𝕧𝕠𝕔𝕒𝕕𝕒 𝕪 𝕟𝕠 𝕥𝕖𝕟𝕚́𝕒𝕟 𝕟𝕚 𝕚𝕕𝕖𝕒, 𝕟𝕚 𝕚𝕕𝕖𝕒, 𝕟𝕠 𝕤𝕒𝕓𝕚́𝕒𝕟 𝕟𝕒𝕕𝕒 𝕕𝕖 𝕝𝕠 𝕢𝕦𝕖 𝕖𝕤𝕥𝕒𝕓𝕒𝕟 𝕕𝕚𝕔𝕚𝕖𝕟𝕕𝕠. 𝕆𝕓𝕧𝕚𝕠 𝕤𝕖 𝕕𝕖𝕕𝕚𝕔𝕒𝕟 𝕒 𝕙𝕒𝕔𝕖𝕣 𝕧𝕚𝕕𝕖𝕠𝕤 𝕖𝕟 𝕐𝕠𝕦𝕋𝕦𝕓𝕖 𝕖𝕟 𝕧𝕖𝕫 𝕕𝕖 𝕥𝕣𝕒𝕓𝕒𝕛𝕒𝕣. 𝕐𝕠 𝕤𝕖́ 𝕝𝕒 𝕚𝕣𝕠𝕟𝕚́𝕒 𝕕𝕖 𝕝𝕠 𝕢𝕦𝕖 𝕖𝕤𝕥𝕠𝕪 𝕞𝕖𝕟𝕔𝕚𝕠𝕟𝕒𝕟𝕕𝕠. ℙ𝕖𝕣𝕠 𝕖𝕤𝕥𝕠 𝕚𝕟𝕔𝕝𝕦𝕪𝕖 𝕗𝕚𝕟𝕖 𝕥𝕦𝕟𝕚𝕟𝕘, 𝕠𝕟𝕖 𝕤𝕙𝕠𝕥, 𝕫𝕖𝕣𝕠 𝕤𝕙𝕠𝕥, 𝕗𝕠𝕣𝕔𝕖 𝕤𝕥𝕣𝕦𝕔𝕥𝕦𝕣𝕖 𝕠𝕦𝕥𝕡𝕦𝕥 𝕖𝕟𝕥𝕣𝕖 𝕠𝕥𝕣𝕒𝕤 𝕥𝕖́𝕔𝕟𝕚𝕔𝕒𝕤, 𝕖𝕟𝕥𝕖𝕟𝕕𝕖𝕣 𝕢𝕦𝕖́ 𝕖𝕤 𝕝𝕒 𝕕𝕖𝕤𝕥𝕚𝕝𝕒𝕔𝕚𝕠́𝕟 𝕕𝕖 𝕞𝕠𝕕𝕖𝕝𝕠𝕤 𝕪 𝕔𝕠́𝕞𝕠 𝕖𝕟𝕥𝕖𝕟𝕕𝕖𝕣 𝕦𝕟 𝕞𝕠𝕕𝕖𝕝𝕠 𝕕𝕖𝕤𝕥𝕚𝕝𝕒𝕕𝕠 𝕪 𝕔𝕠𝕣𝕣𝕖𝕣𝕝𝕠, 𝕔𝕦𝕒́𝕝𝕖𝕤 𝕤𝕠𝕟 𝕝𝕠𝕤 𝕓𝕖𝕟𝕔𝕙𝕞𝕒𝕣𝕜𝕤 𝕕𝕖 𝕝𝕠𝕤 𝕝𝕝𝕞𝕤 𝕪 𝕖𝕩𝕡𝕣𝕖𝕤𝕚𝕠𝕟𝕖𝕤 𝕣𝕖𝕘𝕦𝕝𝕒𝕣𝕖𝕤 𝕕𝕖 𝕥𝕠𝕕𝕒 𝕝𝕒 𝕧𝕚𝕕𝕒. 𝔼𝕝 𝕔𝕦𝕣𝕤𝕠 𝕟𝕦𝕖𝕧𝕠 𝕕𝕖 𝕗𝕦𝕟𝕕𝕒𝕞𝕖𝕟𝕥𝕠𝕤 𝕕𝕖 𝕚𝕟𝕘𝕖𝕟𝕚𝕖𝕣𝕚́𝕒 𝕤𝕠𝕗𝕥𝕨𝕒𝕣𝕖.

𝔼𝕝 𝕕𝕖𝕤𝕒𝕣𝕣𝕠𝕝𝕝𝕠 𝕥𝕖𝕔𝕟𝕠𝕝𝕠́𝕘𝕚𝕔𝕠 𝕤𝕖 𝕙𝕒 𝕔𝕠𝕟𝕧𝕖𝕣𝕥𝕚𝕕𝕠 𝕖𝕟 𝕦𝕟 𝕔𝕒𝕞𝕡𝕠 𝕕𝕖 𝕓𝕒𝕥𝕒𝕝𝕝𝕒 𝕡𝕒𝕣𝕒 𝕝𝕒 𝕣𝕚𝕧𝕒𝕝𝕚𝕕𝕒𝕕 𝕘𝕖𝕠𝕡𝕠𝕝𝕚́𝕥𝕚𝕔𝕒, 𝕖𝕤𝕡𝕖𝕔𝕚𝕒𝕝𝕞𝕖𝕟𝕥𝕖 𝕖𝕟𝕥𝕣𝕖 𝔼𝕤𝕥𝕒𝕕𝕠𝕤 𝕌𝕟𝕚𝕕𝕠𝕤 𝕪 ℂ𝕙𝕚𝕟𝕒. 𝕄𝕚𝕖𝕟𝕥𝕣𝕒𝕤 𝕆𝕔𝕔𝕚𝕕𝕖𝕟𝕥𝕖 𝕕𝕖𝕓𝕒𝕥𝕖 𝕤𝕠𝕓𝕣𝕖 𝕝𝕒 𝕡𝕣𝕚𝕧𝕒𝕔𝕚𝕕𝕒𝕕 𝕪 𝕤𝕖𝕘𝕦𝕣𝕚𝕕𝕒𝕕 𝕕𝕖 𝕒𝕡𝕝𝕚𝕔𝕒𝕔𝕚𝕠𝕟𝕖𝕤 𝕔𝕠𝕞𝕠 𝕋𝕚𝕜𝕋𝕠𝕜, ℂ𝕙𝕚𝕟𝕒 𝕤𝕚𝕘𝕦𝕖 𝕒𝕕𝕖𝕝𝕒𝕟𝕥𝕖 𝕔𝕠𝕟 𝕤𝕦 𝕒𝕧𝕒𝕟𝕔𝕖 𝕥𝕖𝕔𝕟𝕠𝕝𝕠́𝕘𝕚𝕔𝕠, 𝕒𝕡𝕒𝕣𝕖𝕟𝕥𝕖𝕞𝕖𝕟𝕥𝕖 𝕤𝕚𝕟 𝕡𝕣𝕖𝕤𝕥𝕒𝕣 𝕒𝕥𝕖𝕟𝕔𝕚𝕠́𝕟 𝕒 𝕖𝕤𝕥𝕒𝕤 𝕔𝕠𝕟𝕥𝕣𝕠𝕧𝕖𝕣𝕤𝕚𝕒𝕤. 𝔸𝕙𝕠𝕣𝕒 𝕖𝕝 𝕛𝕦𝕖𝕘𝕠 𝕖𝕤 𝕡𝕒𝕣𝕒 𝕥𝕠𝕕𝕠 𝕖𝕝 𝕞𝕦𝕟𝕕𝕠. 𝕍𝕖𝕟 𝕒 𝕛𝕦𝕘𝕒𝕣 𝕖𝕝 𝕛𝕦𝕖𝕘𝕠, 𝕤𝕚 𝕕𝕖𝕡𝕖𝕟𝕕𝕖𝕤 𝕡𝕚𝕖𝕣𝕕𝕖𝕤, 𝕙𝕦𝕪𝕖.

CREDITS:

Image: I, II.Artificial Intelligence, with the help of COPILOT (Designer) and with the support of VileTIC Innovation, III

CoolText

Dedicɑted to ɑll those poets who contɾibute, dɑγ bγ dɑγ, to mɑke ouɾ plɑnet ɑ betteɾ woɾld.

Congratulations @amigoponc! You received a personal badge!

Wait until the end of Power Up Day to find out the size of your Power-Bee.

May the Hive Power be with you!

You can view your badges on your board and compare yourself to others in the Ranking

Check out our last posts:

Congratulations @amigoponc! You have completed the following achievement on the Hive blockchain And have been rewarded with New badge(s)

You can view your badges on your board and compare yourself to others in the Ranking

If you no longer want to receive notifications, reply to this comment with the word

STOPCheck out our last posts:

@amigoponc, I paid out 0.008 HIVE and 0.000 HBD to reward 2 comments in this discussion thread.