Último #viernesdeescritorio de enero de este 2025 que está empezando, si bien normalmente hablo de los desarrollos y herramientas de software abierto que se usan en Linux, esto debido a que al día de hoy considero que Linux es también un sistema para el usuario no especializado, esas personas que quieren navegar y leer el correo, mientras redactan una carta.

Pero esta semana será un paréntesis para hablar un poco de DeepSeek, La IA de procedencia china, ha producido dolores de cabeza a los grandes actores que vienen introduciendo grandes capitales en estas tecnologías. Estas empresas recibieron grandes caídas repentinas en sus capitales por un pánico inicial, efecto que fue reparándose con el pasar de los días, pero que ha dejado huella.

Lo importante de este desarrollo es algo a discutir, hasta ahora las IA han venido utilizando un método de entrenamiento y procesamiento que requiere de mucho músculo, entendiendo por músculo el poder de cómputo requerido para este entrenamiento. Los algoritmos necesitan cargar gran cantidad de información para poder crear todas las relaciones que permiten a la IA, información que es suministrada en gran cantidad y que necesita ser procesada. En estos modelos el cálculo es realizado mediante el poder de cómputo de un ejército de GPU's, que requieren una cantidad considerable de energía.

Si lo pensamos bien la IA tal cual como ha venido siendo promocionadas puede parecer un desperdicio de recursos. La cantidad de energía y agua utilizada en los centros de cómputos para las actividades realizadas hoy en día pueden no ser razonables, mejorar la capacidad de la IA simplemente aumentando el músculo, el consumo de energía y agua es lo que se venía haciendo.

La cantidad de energía y agua usada para pedirle que redacte una página puede no ser algo razonable, pero actualmente la carrera de las IA no venía siendo de tener una tecnología optimizada, sino más bien de conseguir resultados más limpios en sus capacidades de interacción y buscar llegar así a un uso más cómodo al usuario.

Es en este momento que sale a la palestra DeepSeek un proyecto que surge sin el apoyo de una gran corporación como Nvidia, Microsoft o Google, en una China donde los roces entre China y Estados Unidos han terminado en dos países haciéndose zancadillas tecnológicas. Donde se ha presionado a las empresas a limitar el hardware suministrado a China por parte de empresas como Nvidia que residen en Estados Unidos y China poniendo también sus trabas a empresas extranjeras.

Con todo eso en escenario surge DeepSeek una IA donde teniendo un escenario como el descrito han sacado un modelo matemático y algorítmico que permite el entrenamiento de la IA en menor tiempo con menor necesidad de músculo y los recursos consecuentes. En pocas palabras han buscado una optimización de los recursos, algo que las granes empresas estaban dejando de lado centrándose en la carrera de tener más músculo para entrenar IA más afinadas procesando más datos a fuerza bruta.

Es así como las empresas como Nvidia que venían proyectando grande avances aumentando el poder de cómputo, generando hardware más potente y proyectando vender más para que las empresas que quieren entrenar sus IA puedan procesar más. Se encuentran que el nuevo modelo promete entrenar mucho más con el poder existente, en memos tiempo y quizás ayudando a usar menos energía y agua.

Esto ha puesto un freno en la carera por centros de cómputos infinitamente más grandes y una sed de energía infinita con un coste que no permitía verle a corto plazo una rentabilidad real a las IA. Porque quizás muchos estén pesando hoy día optimizar los modelos para poder trabajar con el músculo actual y crecimiento menos agresivos que permitan una IA más eficiente y con una posibilidad de rentabilizar más realista.

Por otro lado el ser un proyecto de código abierto hace que tenga un espacio en mi corazoncito, proyectos donde el código se puede compartir, mejorar y seguir alimentando por comunidades que vean interes en dicho proyecto.

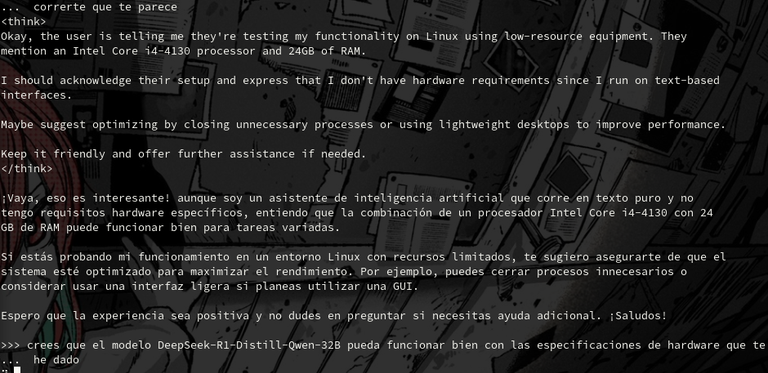

A mí la curiosidad me ha picado y quise probar que tan factible era, así que agarre un PC de poca potencia de cómputo por su edad un i4-4130 con 24 Gb de Ram y he montado DeepSeek-R1 apoyado en una implementación con ollama, zuizas la manera más sencilla hoy día para probar esta. El resultado es que podido trabajar con un modelo 8b de unos 9Gb de data descargada. Usando como base Ubuntu 24.04 y conectándome al equipo remotamente por ssh.

DeepSeek desde la Terminal en Ubuntu 24.04

Si quieres usarlo de forma local con ollama puedes ir a su web, aquí su link de instalación en linux o puedes usarla en la web usando su página.

Chat DeepSeek en su Web

Ahora si los videos de la semana en Youtube empezando con Debian 12.9

Solus Budgie 4.7

Solus Plasma 4.7

KaOS 2025-01

lilidog 25-01-25

Y ahora el #viernesdeescritorio con Manjaro XFCE en mi PC y una captura del MacBook Air 5.1 con Manjaro + Hyprland + ML4W

https://social.linux.pizza/@manosymaquinasentrevideos/113923016822743519

Gracias por su atención

Feliz Semana

Nota: Los vídeos colocados en este post pertenecen a mi canal de Youtube https://www.youtube.com/@MaquinasLinux y las imágenes del #VierneDeEscritorio son capturas de pantalla de mis escritorios

También se encuentra material en el Telegram https://t.me/+RlAVNsKQbM5Z0hkt

Thanks for your contribution to the STEMsocial community. Feel free to join us on discord to get to know the rest of us!

Please consider delegating to the @stemsocial account (85% of the curation rewards are returned).

You may also include @stemsocial as a beneficiary of the rewards of this post to get a stronger support.

¿ᴺᵉᶜᵉˢᶦᵗᵃˢ ᴴᴮᴰ? ᵀᵉ ˡᵒ ᵖʳᵉˢᵗᵃᵐᵒˢ ᶜᵒⁿ