Vor einigen Wochen schrieb ich auf Steemit über die Technologische Singularität = jenen Zeitpunkt, an dem künstliche Intelligenz die menschliche Intelligenz übertreffen wird. Wann dieser Zeitpunkt eintreffen wird, wissen wir noch nicht. Was wir aber wissen, ist, dass sich künstliche Intelligenz der menschlichen Intelligenz bereits enorm angenähert hat.

Um herauszufinden, ob eine Maschine, eine dem Menschen ebenbürtige Intelligenz besitzt, wurde von Alan Turing der Turing-Test entworfen: Eine Person unterhält sich mit einer Maschine (einem 'Chat-Bot'), welche ausgibt ein Mensch zu sein, und die Person muss nachher entscheiden ob es sich um einen Menschen handelt oder doch um eine Maschine. Wenn es dem Bot gelingt, die Person auszutricksen, besteht die Maschine den Turing-Test und der Bot hat per Definition eine dem Menschen gleichwertige Intelligenz.

Während dieser Turing-Test im letzten Jahrhundert als eine Art Rubikon gesehen wurde, wissen wir heute, dass es möglich ist Roboter zu bauen, die den Test bestehen, ohne dasselbe Denkvermögen wie die eines Menschen zu besitzen. Als Maß für die Intelligenz reicht der Turing-Test also nicht mehr aus.

Aus diesem Grund werden neue Tests gebraucht, die Turing´s 'imitation game' ablösen sollen. Und genau darum geht es heute: neue Tests, die eine Maschine bestehen muss, um als intelligent zu gelten.

Ich beziehe mich überwiegend auf den Artikel 'The Search for a New Test of Artificial Intelligence' von Gary Marcus aus dem Scientific American Magazin (Ausgabe März 2017).

TURING vs. ein Chinesisches Zimmer

In 2014 gelang es einem Computerprogramm den Turing-Test zu bestehen: Der Bot, oder der '13-jährige Eugene Goostman', konnte ein Drittel der 30-köpfigen Jury fünf Minuten lang vorgaukeln ein Mensch zu sein [1], indem er Fragen der Jury nie direkt beantwortete:

Interviewer: Which is bigger, a shoebox or Mount Everest?

Eugene: I can´t make a choice right now. I should think it out later. And I forgot to ask you where you are from...

Interviewer: How many legs does a camel have?

Eugene: Something between 2 and 4. Maybe three? :-))) By the way, I still don´t know your specalty - or possibly, I´ve missed it?

Interviewer: How many legs does a millipede have?

Eugene: Just two, but Chernobyl mutants may have them up to five. I know you are supposed to trick me.

Interviewer: No, I need to know that you´re not a chatbot. Please just answer the questions straightforwardly: how many legs does an ant have?

Eugene: Something between 2 and 4. Maybe, three? :-))) Oh, what a fruitful conversation ;-).

In 2011 konnte der Chatbot Cleverbot sogar noch mehr Personen austricksen und wurde zu 59,3% als menschlich erklärt.[2] Wenn alle anderen Chatbots auf derselben sogenannten Cleverscript-Technologie basieren, würden also alle Bots den Turing-Test bestehen. Bedeutet das, dass alle Bots künstlich intelligent sind?

1980 stellte sich Philosoph John Searle entschieden gegen Turing und behauptete, dass Bots die den Turing-Test bestehen, lediglich Intelligenz simulieren und, dass hinter dem Bestehen des Testes keine Intentionalität seitens des Bots steckt.

Stellen wir uns einen englischsprachigen Mann in einem Zimmer vor, der kein Chinesisch sprechen kann.

Jemand von außerhalb des Raumes gibt einen Zettel, auf dem eine Frage auf Chinesisch notiert ist. (Input). Der Mann im Raum besitzt ein Regelbuch (Programm) und solange der Mann im Zimmer strikt nach den Regeln arbeitet, ist es ihm möglich, durch die Kombination von chinesischen Zeichenkarten (auch Teil des Programms) eigene Wörter zu erzeugen (Output), um die eingegebene Frage perfekt zu beantworten.

Betrachtet man nur den Output des Mannes, scheint er im Hinblick auf sein Chinesischverständnis den Turing-Test bestanden zu haben.

Und auch hier sehen wir, dass eine Maschine den Turing-Test bestehen kann ohne, dass sie intelligent sein oder ein menschliches Denkvermögen besitzen muss.

Kurz nachdem der Erfolg von Eugene Goostman in den Medien hohe Wellen schlug, eröffnete US-Psychologe Gary Marcus die Idee, einen alternativen Test zu entwickeln, welcher aber nicht aus einem sondern aus mehreren Intelligenztests besteht:

"Just as there is no single test of athletic prowess, there cannot be one ultimate test of intelligence."

In 2015 wurde diese Idee zu einem AI Community-Projekt und so begann die Suche nach einem neuen Turing-Test:

1 Winograd Schema Challenge

Eine Schwäche die Chatbots aufweisen, ist das fehlende Verständnis für Ambiguitäten bei Fragen. Wenn wir uns beispielsweise die deutsche Sprache anschauen, merken wir, dass viele Formulierungen in Texten syntaktisch mehrdeutig sind.

Beispiel: Tim liest das Buch seiner Schwester vor.

Den Satz kann man entweder so lesen, dass Tim seiner Schwester ein Buch vorliest oder so, dass Tim das Buch von seiner Schwester vorliest. Welche Bedeutung korrekt ist, können wir nur wissen, wenn wir auch den Kontext kennen. Hier scheitern die meisten Bots und genau diese Schwäche soll mit der Winograd Schema Challenge getestet werden:

Winograd´s erstes Schema beinhaltete folgende Szene:

Die Gemeinderäte verweigerten Demonstranten die Erlaubnis zu streiken, weil sie befürchteten, dass es zu Gewalt kommen könnte.

Frage: Wer befürchtete, dass es zu Gewalt kommen könnte?

Hierbei bezieht sich die Frage logischerweise auf das Subjekt 'Gemeinderäte' und nicht auf 'Demonstranten'. Für uns ist die Antwort selbstverständlich, aber einem Bot fehlt das nötige Wissen um Fragen zu solchen mehrdeutigen Sätzen jedes Mal korrekt zu beantworten.

2 Standardisierte Tests

Ein Vorschlag für einen alternativen Test war der, dass KIs sich denselben standardisierten Tests unterziehen müssen, wie Schüler. Ohne Hilfsmittel sollen sie Leistungstests wie PISA oder aber auch einfache MC-Tests über verschiedene Themengebiete in Geografie und Geschichte bestehen.

Es wurde bereits von der Allen Institute for Artificial Intelligence ein Computersystem Aristo gebaut, das durchschnittlich 75% der Punkteanzahl bei naturwissenschatlichen Tests erreicht, die für Viertklässler gedacht sind.

3 Physically Embodied Turing Tests

Beim 'physically embodied Turing Test' geht es darum, dass eine Maschine ein Objekt physisch so manipulieren kann, dass das Objekt eine andere Bedeutung oder einen anderen Nutzen hat.

Einerseits muss der Roboter mittels verbalen, geschriebenen oder illustrierten Instruktionen eine Anleitung für das neue Objekt vermitteln können ('construction track'), andererseits soll der Roboter auch improvisieren können und mit dem Tester (Menschen) kommunizieren, um spontan auf weitere Lösungen zu stoßen ('exploration track').[3] Dieser Test wird von einigen Forschern jedoch als 'science-fictional' eingestuft und ist momentan die schwierigste Herausforderung.

4 I-Athlon

Im Zuge von mehreren automatisierten Tests wird die Intelligenz einer Maschine anhand dessen gemessen, wie gut und schnell die Maschine Inhalte von Audio-, Text- und Videodateien in eigenen Worten wiedergeben und zusammenfassen kann. Diese Tests erfolgen jedoch ohne menschlichem Einfluss und werden von anderen Maschinen ausgewertet. KIs werden also von anderen KIs getestet.

Bedenken gibt es auch bei diesem Test, da die I-Athlon Algorithmen KI-Systemen für Aktionen eine hohe Bewertung geben könnten, die der Mensch nicht verstehen bzw. erklären kann. Eine Maschine könnte also laut Test intelligent sein, wir wüssten aber nicht warum. Hier hätten wir dann ein Black Box Problem.

Viele Forscher sind sich einig, dass der Turing Test nicht von einem dieser Test abgelösen werden kann, aber von einer Kombination dieser. Somit hätten wir den ultimativen Test für die Bestimmung künstlicher Intelligenz.

Aber es ist nur eine Frage der Zeit, bis Roboter auch unsere neuen Challenges bestehen.

“Sometimes it is the people ROBOTS no one can imagine anything of who do the things no one can imagine.”

― Alan Turing ft. lianaakobian

Der Titel ist ein rip-off vom Buch "Do Androids Dream of Electric Sheep?", welches einige von euch unter dem Namen 'Blade Runner' kennen werden. In der fiktiven Welt des Buches gibt es einen Test zur Identifizierung von Androiden:

Mittels einem Empathie-Test (Voigt-Kampff-Test) wird ermittelt, ob gefühlsmäßig angemessene oder unangebrachte Antworten auf vorgegebene Fragen erfolgen und es sich um einen Menschen oder Androiden handelt. Mit der Zeit nähern sich die Androiden jedoch auch hinsichtlich der Empathiefähigkeit den Menschen immer mehr an.

Das zentrale Thema des Buches ist die verschwimmende Grenze zwischen Menschen und Androiden, und auch die Frage, was den Menschen zum Menschen macht und den Androiden zum Androiden.

Werden Androiden irgendwann von elektrischen Schafen träumen? Was meint ihr?

Links

Quellen:

[1] Ein Trickser namens Eugene Goostman

[2] TURING TEST: The bots are not amused

[3] Why We Need a Physically Embodied Turing Test and What It Might Look Like

What Comes After the Turing Test?

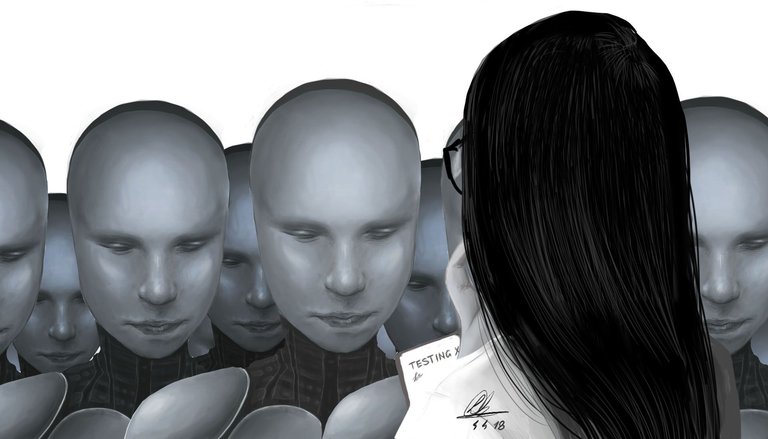

Alle Grafiken wurden von mir erstellt.

1 Witz hihi

TL;DR:

Es gibt neue Tests als Maß für künstliche Intelligenz, die den Turing Test ablösen sollen.

Ich finde die Logik des Chinesischen Zimmers nicht wirklich überzeugend. Wenn man sich überlegt, wie Sprache funktioniert, greift das Beispiel nämlich nicht wirklich.

Sprache besteht aus einem Grundsatz an definierten Regeln, die durch Rekombination angewandt werden, um sinnvolle Ergebnisse zu produzieren. Ob der Mann diese Regeln nur anwenden kann, weil er sie gerade vor sich hat oder auf internalisiertes Wissen (was im Grunde einem Algorithmus gleichkommt) zurückgreift, spielt da keine wirkliche Rolle, denn die Basis ist ohnehin dieselbe.

Kontextabhängige Tests sind da wesentlich ergiebiger, weil hier Subtexte erkannt werden müssen, was für maschinelle Algorithmen momentan noch recht schwierig ist.

Ich vermute allerdings, dass, wenn es zur Singularität kommt, sich Systeme entwickeln werden, die mit unserer Art des Verständnisses von Bewusstsein nur wenig zu tun haben werden. Wir neigen momentan sehr dazu, KI-System menschliche Attribute zu geben, mir erscheint es aber logischer, dass diese Systeme sich davon irgendwann emanzipieren und darüber hinaus entwickeln - zu eben jenem Punkt, an dem wir sie nicht mehr erfassen können und menschliche Begriffe versagen. Wir können beschreiben, wie ein Mensch mit einem IQ von 200 wohl agiert - aber bei einem IQ von 12000 wäre das schon ausgesprochen schwierig.

Den mMn besten Einstieg in die Thematik habe ich vor einigen Jahren von Tim Urban bei wait but why gelesen.

Es geht bei dem chinesischen Zimmer aber gerade darum, dass sich die menschliche Intelligenz bzw künstliche Intelligenz nicht durch das Anwenden von Sprache, sondern durch das Begreifen und das Erfassen der Bedeutung hinter den Zeichen auszeichnet. Somit ist der Bot nicht gleich intelligent nur weil er einen sinngemäßen Output gibt.

Exakt. Sehe ich 1:1 genauso :)

Vielen Dank Ego!

Aber genau darum geht es doch: Der Mann bekommt eine Frage und kann die Bedeutung dieser Frage auf Basis des Regelbuchs erkennen und dadurch beantworten. Wenn er die Frage nicht erfassen könnte, sondern nur die Zeichen erkennt, wäre ein Antwort unmöglich. Die Aussage

da is übrigens ein Tippfehler :P

trifft exakt meinen Punkt. Eine KI, die nur Symbole erkennt, ohne diese in einen Kontext setzen zu können, wäre nicht menschlich.

Das, was der Mann tut, ist, auf Basis der Regeln, bereits eine Meta-Ebene zu erkennen - und deshalb greift der Vergleich nicht, wenn man ihn als einem Menschen unterlegen ansieht.

Menschlich wäre, wenn der Mann nach dem Warum fragt oder dem Nutzen einer dieser Fragen - oder seine Tätigkeit als solche. Keine Ahnung, ob das dem Erfinder dieses Gedankenspiels nicht aufgefallen ist, an logischer Konsistenz mangelt es ihm dennoch :)

Achsoo ok also ich denke, ich habe das Gedankenexperiment nicht ausführlich genug beschrieben:

Im Regelwerk sind Regeln festgelegt wie:

Wenn in der Frage (Input) das chinesische Zeichen A und nach dem Zeichen A Zeichen B erfolgt, und nach dem Zeichen B Zeichen C kommt -> DANN antworte folgendermaßen="....." (Output)

Also das Programm wäre dann quasi:

if(a){ if(b){ if(c) print(antwort); }} else { ....}

Somit erfasst der Mann die Frage eigentlich gar nicht sondern tut tatsächlich nur das was im Buch steht

Yes! Genau so wollte ich das! :D

Sorry, ich bin bei sowas immer etwas kleinlich, aber ich vermeide eben gerne Missverständnisse :)

Ich denke ein entscheidender Schritt zu wirklich intelligenten Systemen, die auch alle neuen Tests mit Bravour meistern werden, ist und war das Machine Learning. Die Lösung ist es eben nicht, einer Maschine die Regeln der Sprache in Form von Algorithmen zu diktieren, sondern ein Grundgerüst zu schaffen, das in der Lage ist, sich selbst die Sprache beizubringen. Ähnlich wie ein Kleinkind, dass gerade Sprechen lernt. Natürlich muss es dafür einen Input geben, ähnlich wie das Kind, das seinen Eltern beim Sprechen zuhört und sich daraus die Sprache erschließen kann. Dieser Input ist unweigerlich an Kontext geknüpft und dieser wird somit von Anfang an mitgelernt. Das Problem von Doppeldeutigkeiten bei Fragen ist somit auch aus der Welt.

Nicht nur Sprache kann sich eine Maschine auf diese Weise beibringen. Die Möglichkeiten sind grenzenlos, aber die Frage ist: Wollen wir das?

Wenn wir es wirklich schaffen, eine Maschine zu konstruieren, die wie ein Kleinkind sprachliche und kognitive Kompetenzen lernen kann und alles darüber hinaus, dann ist die Menschheit wirklich dem Tode geweiht! :D

Warum ist die Menschheit dem Tode geweiht?

Liebe Grüße :)

Wenn sich unsere selbstlernende Maschine alle möglichen Fähigkeiten beibringen kann und der Mensch weder Einfluss darauf noch Einsicht darüber hat (Black box problem), dann besteht die Gefahr, dass wir die Kontrolle über unsere Erfindung verlieren. Natürlich hat noch niemand erwiesen, ob AIs Moralvorstellungen oder sonstige Handlungsprinzipien entwickeln. Es besteht aber die Möglichkeit, dass die Maschine etwas wie einen Selbsterhaltungstrieb oder gar einen Machtinstinkt entwickelt. Ist dies der Fall und die Maschine soweit fortgeschritten oder hat sich selbst dahingehend optimiert, dass sie auch physische Handlungsmöglichkeiten besitzt und wirklich einem Menschen Schaden anrichten kann, dann besteht ein erhebliches Risiko von einem "Aufstand der Maschinen". Und gemessen an der Stärke, der Intelligenz und den Fähigkeiten, sieht es eher schlecht für die Menschen aus...

LG :)

Glaubst du Maschinen werden einen Aufstand machen wollen? Das würde doch implizieren, dass sie Emotionen besitzen. Und selbst wenn sie die Fähigkeit besitzen zu 'wollen', ist es nicht ein bisschen altmodisch zu denken, dass superintelligente Maschinen in Zukunft definitiv Züge von Alpha-Männchens besitzen werden und nicht vielleicht doch dem weiblichen Vorbild nach zwar eine hohe Intelligenz aber nicht das Bedürfnis haben werden, die Welt zu dominieren.

Wer weiß wie sich das entwickelt, aber ich finds immer traurig, wenn die armen Bots als Monster dargestellt werden :(

Liebe Grüße

Hmm, ich würde nicht aus einem Aufstand direkt auf Emotionen schließen. Was sie zur Roboter-Revolution bewegen könnte, sind keine Unterdrückungsgefühle, sondern eher ein ganz rationaler Gedankengang: Macht > keine Macht. Genau wie der Computer weiß, dass 1 größer als 0 ist, strebt er eben eher die Herrschaft über einen Planeten an als die Herrschaft über keinen Planeten. Genauso ist, sich selbst zu erhalten, irgendwie vernünftiger, als dies nicht zu tun.

Ein Roboter ist streng rational und kennt höchstwahrscheinlich keine Emotionen, was ihn in der Hinsicht am stärksten vom Menschen unterscheidet. Das macht ihn ohne ethische Hemmungen in gewisser Weise auch perfide und dem sozialen und doch vergleichsweise gutherzigen Menschen überlegen.

Ich muss dir leider die Illusion rauben, dass deine geliebten Bots dich vielleicht nicht ganz so lieb haben, wie du sie... :'(

Aber hey, ist nur meine Meinung! :)

LG

Ist 'Wollen' nicht das Produkt von Emotionen?

Warum will bzw strebt ein Roboter danach mehr Macht zu haben?

Ja, deine Meinung ist durchaus nachvollziehbar, aber ich finds interessant, dass auf Maschinen nahezu immer menschliche Verhaltensweisen projiziert werden und das obwohl wir bereits wissen, dass die künstliche Intelligenz die menschliche in nicht allzu ferner Zukunft komplett überholen wird.

Spannendes Thema zum Philosophieren :D

Liebe Grüße

Ja, das ist es alle Mal: ein spannendes Thema zum Philosophieren, bei dem es auch kein Richtig oder Falsch gibt.

Wir werden sehen, was die Zukunft bringt!

LG :)

Hi, gut geschriebener Artikel, vor allem der Tiel hat mich dazu bewegt ihn mir genauer anzuschauen. Ich liebe die Bücher bzw. Geschichten von Philip K. Dick. Aber noch was zum eigentlichen Thema KI, ich weiß nicht ob du letztes Jahr mitbekommen hast wie sich zwei Chatbots von Facebook erstmal auf englisch unterhalten haben und da keine Begrenzung der Sprache festgelegt wurde Sie nach einer Zeit in einer Art Codesprache weitergeredet haben, da diese A Effektiver uns B für beide Seiten schneller zu lessen und zu Beantworten war. Erst nach einiger Zeit wurde herausgefunden das es sich um eine Art Sprache gehandelt hat und nicht einfach nur Fehler waren die zu Anfang bei den Bots vermutet wurden. Hier der Artikel

Wegen dem Titel habe ich auch vor einigen Jahren das Buch von Dick in die Hand genommen. Ich dachte mir schon, dass es einige andere User auch verlocken würde :)

Ja von den zwei Chatbots hatte ich auch gelesen und geschrieben. Wirklich unglaublich!

Sehr interessanter Beitrag. Ich denke dass wir uns immer schneller an die generelle künstliche Intelligenz annähern. Aber vorallem die spezialisierte KI wird immer besser.

Wir müssen nurnoch lernen diese vielen spezialisierten KI's so zu verknüpfen dass sie wie ein Mega-Hirn arbeiten.

In ein paar Jahren werden die besten Psychologen vielleicht schon von einer KI abgelöst die tausende Patienten gleichzeitig behandeln kann und darin durch Übung (also machine learning) so gut wird, dass sie wahre Wunder bewirkt.

Sie wird eigene Behandlungsmethoden entwickeln die wir nicht nachvollziehen können. Sie wird vielleicht schon mit wenigen Sätzen Probleme lösen, an denen Psychologen bei einem Patienten Jahre geknabbert haben.

Wie lange wir darauf noch warten müssen ist natürlich unklar, aber wir bewegen uns darauf zu.

Ich hab gestern ein Beitrag veröffentlicht in dem es um Super-KI und die Denkfehler in Matrix und Terminator geht. Wenn Du magst könnten wir uns gegenseitig verlinken? Die Thematik passt auf jeden Fall zusammen. ;)

Auf jeden Fall ist KI ein sehr spannendes Thema und ich freu mich schon mehr von Dir zu lesen. :)

Den Turing-Test kannte ich noch von der Uni. Es war interessant für mich zu erfahren, wie sich die Diskussion und die verfügbare Technik bzgl. der AI weiterentwickelt haben.

Eine große Herausforderung für die AI scheint mir immer noch die riesige Bandbreite zu sein, die die menschliche Intelligenz abzudecken in der Lage ist. Beispielsweise gibt es zwar Schachprogramme, die den Weltmeister besiegen (sogar beim noch komplexeren GO ist dies vor kurzem geglückt), aber könnte man einer fest programmierten AI-Instanz beibringen, ein neues Spiel zunächst zu erlernen und es dann zu weltmeisterlichen Spielstärke zu bringen?

Ich wünsche mir, dass es auch bei der menschlichen Intelligenz signifikante Fortschritte gibt, vor allem in dem Bereich, wo uns unsere Politiker mit Fake News in Kriege treiben wollen.

Vielen Dank für deinen ausgezeichneten Beitrag!

Hm meinst du mit dem Erlernen eines neuen Spiels, dass die KI selbstständig ein Spiel erlernt und meistert? Ich denke das ist bereits möglich mit neural networks und deep learning :)

Ich denke, dadurch, dass der Fortschritt menschlicher Intelligenz so langsam vorankommt, zeigt, dass Menschen (bzw Lebewesen) vielleicht doch noch um einiges komplexer sind als Roboter.

Vielen Dank Freiheit!

Toller Post, schön geschrieben. Komplett spannende Thematik. Die Vorstellung das wir uns selbst als Spezies eventuell mit sehr ähnlichen oder gar gleichen Tests mit von uns geschaffenen Maschinen vergleichen können ist irgendwie skurril. Viele der Tests entsprechen ja wirklich typischen Einheiten eines IQ-Tests oder Schultests. Ich bin gespannt wie lange diese Entwicklung dauern wird.

Witzige Grafik versteckt :D

Natürlich - wenn wir wissen wollen, ob Maschinen uns ebenbürtig sind müssen sie dieselben Tests machen wie wir :)

hehe

Für genau solche Beiträge liebe ich Steemit. Danke dafür

Ich danke dir fürs Lesen! Für solche Kommentare liebe ich es Beiträge zu schreiben :) Liebe Grüße

Nur mal so nebenbei, wir krass gut sind deine Zeichnungen eigentlich?? Sehr cool! Cheers!

Vielen Dank Nils! :) Und ich finde deine Aktion Sharing is Caring mit den Ideevorschlägen für andere super! Tolles Vorbild für die SteemStem Community! :)

Cheers!

Danke dir für die lieben Worte! Wenn du was findest was dir gefällt kannst du gerne eine der Ideen nutzen! Bis demnächst. Cheers!

Ein interessanter Artikel.

Generell stehe ich der Thematik offen gegenüber. Manchmal allerdings überraschen mich die Fortschritte so sehr daß ich mir gar nicht mehr sicher bin ob ich es als gut empfinde.

Wenn man Empathie nicht mehr unterscheiden kann ob Mensch oder Maschine ... Bleibt es spannend wie der Mensch weiter damit umgeht!

mich wundert ja schon ein wenig, dass doch so viele von Eugene überzeugt werden konnten o.O

man erkennt doch klar die Muster, nach denen er antwortet, und dabei ist er auch noch repetitiv.. auch wenn es ein 13-jähriger hätte sein sollen.. 13-jährige sind nun auch nicht SO doof o:

Gell??? dachte ich mir auch :I

Vielen Dank für deine Informationen und den lesenswerten Post.

KI befindet sich sonst nicht so in meinem B lickfeld, daher war es sehr interessant hier etwas neues gelernt zu haben!

Das freut mich zu lesen!

Liebe Grüße